This is an Italian translation of The longtermist AI governance landscape: a basic overview

Obiettivo: fornire una visione d'insieme della governance delle IA dal punto di vista lungoterminista.

A chi è destinato: a persone che non hanno familiarità con la governance delle IA dal punto di vista lungoterminista e vogliono conoscere meglio questo ambito. Non mi aspetto che sarà utile a chi ha già familiarità con queste tematiche. Addendum: alcune persone che avevano già familiarità con queste tematiche hanno trovato utile l’articolo.

Questo post intende delineare i diversi tipi di lavoro coinvolto nella governance lungoterminista delle IA. Darò una breve spiegazione di ognuno, completa di esempi e storie che spiegano in che modo potrebbe avere un impatto positivo, oltre a un elenco delle persone che ci stanno attualmente lavorando di cui sono a conoscenza.[1]

Per prima cosa, un paio di definizioni:

- Governance delle IA lo sviluppo di norme, politiche, leggi, processi e istituzioni (non solo governi) locali e globali che influenzeranno i risultati nella società derivanti dallo sviluppo e dall’impiego delle intelligenze artificiali.[2]

- La governance lungoterminista delle IA, nello specifico, è la sottocategoria motivata dalle preoccupazioni per l’impatto delle IA su un periodo di tempo molto ampio. Coincide spesso con il lavoro che punta a controllare le IA trasformative (TAI).

Vale la pena notare che si tratta di un ambito molto ristretto. Se dovessi ipotizzare direi che ci sono circa 60 persone che lavorano nel campo della governance delle IA e la cui preoccupazione è il suo impatto sul lunghissimo periodo.

Breve riassunto

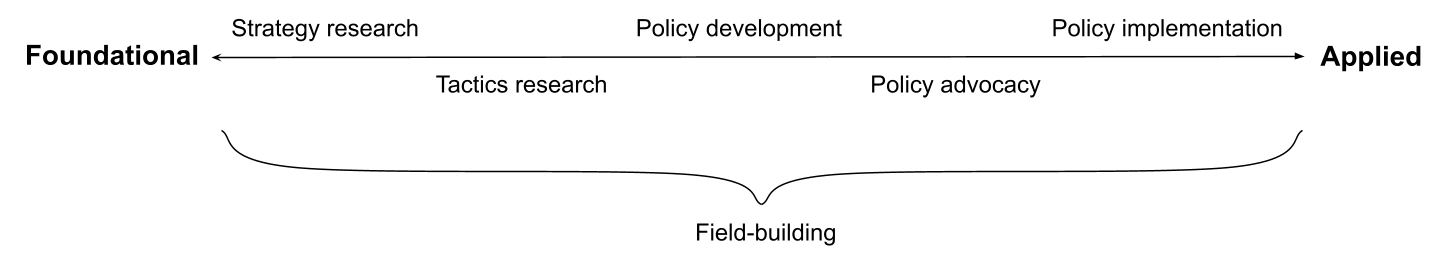

Parlando in astratto, penso sia utile visualizzare il lavoro di base e quello applicato come ai poli opposti di uno spettro. Dal lato del lavoro di base abbiamo la ricerca strategica, il cui scopo è individuare obiettivi astratti ideali per la governance lungoterminista delle IA; c'è poi la ricerca tattica, il cui obiettivo è individuare i programmi utili a raggiungere quegli obiettivi. Dal lato del lavoro applicato troviamo lo sviluppo di normative, il cui scopo è trasformare la ricerca in normative concrete; abbiamo poi lavoro che spinge perché quelle normative vengano applicate e infine l’applicazione vera e propria (ad esempio da parte di impiegati statali).

C'è anche lavoro di field-building (dalla collocazione incerta): invece che contribuire direttamente a risolvere il problema, l’obiettivo è quello di creare un ambito con persone che lavorano sul tema.

Ovviamente si tratta di una semplificazione e non tutti i lavori potranno essere catalogati con precisione. Al contrario di quel che si pensa di solito, non sempre la conoscenza profonda passa dalla base alla parte applicata: è anche importante che la ricerca tenga conto delle preoccupazioni normative, vale a dire quanto è probabile che questa ricerca corrobori una proposta normativa che è fattibile dal punto di vista politico.

Vediamo ora nel dettaglio ognuno di questi ambiti.

Ricerca

Ricerca strategica

In definitiva, l’obiettivo della ricerca strategica lungoterminista sulle IA è quello di individuare obiettivi di alto livello che, se raggiunti, potrebbero chiaramente aumentare le probabilità di risultati positivi, da un punto di vista lungoterminista, da parte di un’IA avanzata (sull’esempio di Muehlhauser, a volte farò riferimento a questo obiettivo come al "raggiungimento di una chiarezza strategica").

La ricerca stessa può essere collocate in vari punti dello spettro compresi tra mirata ed esplorativa:

- L’obiettivo della ricerca strategica mirata è quello di fornire risposte che facciano luce su altre domande specifiche e importanti.

- Ad esempio, "Voglio scoprire qual è la potenza di calcolo del cervello umano, perché mi aiuterà a scoprire quando verranno sviluppate le TAI (cosa che determina gli obiettivi di alto livello che dovremmo ricercare)"

- La ricerca strategica esplorativa fornisce risposte senza avere bene in mente le altre domande importanti a cui potrebbe aiutarci a rispondere.

- Ad esempio, "Voglio scoprire quali sono le politiche industriali della Cina, perché probabilmente saperlo mi aiuterà a rispondere a una serie di domande strategiche importanti, anche se non so esattamente a quali".

Esempi

- Il lavoro delle previsioni sulle TAI, come ad esempio ancore biologiche e leggi scalabili per modelli linguistici neurali.

- Esempio di importanza strategica: se le TAI arriveranno in tempi brevi, allora un ambito di esperti che cresce lentamente sembra poco promettente; se le TAI sono al di là da venire, allora alla governance lungoterminista delle IA potrebbe essere assegnata una priorità minore.

- Il lavoro sulla chiarezza delle fonti dei rischi esistenziali legati alle IA, come gli scritti di Christiano, Critch, Carlsmith, Ngo e Garfinkel.

- Esempio di importanza strategica: se la maggior parte dei rischi esistenziali derivanti dalle IA proviene da IA avanzate non allineate, allora la governance dovrebbe concentrarsi su chi costruisce quelle IA.

- Le ricerche che indagano la velocità dei progressi sulle TAI, ad esempio le indagini e le analisi di AI Impacts.

- Esempio di importanza strategica: se i progressi nelle IA sono discontinui, allora è possibile che ci sia un numero ristretto di protagonisti molto importanti e che la maggior parte del valore della governance risieda nell’influenzare quelle persone.

È facile confondere la ricerca strategica (e soprattutto la ricerca strategica esplorativa) con la ricerca ad ampio spettro. Come mostrano molti degli esempi precedenti, la ricerca strategica può essere obiettivi ristretti, vale a dire che può rispondere a una domanda dalla portata limitata. Esempi di portata limitata e ampia portata:

- Sulle leggi di scala (scaling laws):

- Ampia portata: in generale, come cambiano le prestazioni dei modelli di deep learning se aumentano le dimensioni di quei modelli?

- Portata limitata: in che modo cambiano in particolare le prestazioni di modelli linguistici di grandi dimensioni (come ad esempio GPT-3) se aumentano le dimensioni di quei modelli? (Argomento affrontato in questo paper.)

- Sulle fonti dei rischi esistenziali derivanti dalle IA:

- Ampia portata: in generale, quali rischi esistenziali comportano le IA?

- Portata limitata: quali rischi esistenziali potrebbero derivare nello specifico da IA il cui obiettivo è ottenere influenza? (Argomento affrontato in questo report.)

In effetti, spesso è meglio scegliere domande dalla portata limitata, soprattutto se si è ricercatori di basso rango, perché sono di solito più gestibili.

Luke Muehlhauser ha alcuni consigli per coloro che vogliono cimentarsi in questo tipo di lavoro al punto 4 di questo post. In questo post invece ci sono esempi di domande aperte sulla ricerca.[3]

Storie di impatto

- Impatto diretto: gli obiettivi nel campo della governance delle IA sono molteplici ed è necessario dare priorità a quelli più importanti. Questo tipo di lavoro è spesso motivato dall’impressione dei ricercatori che c'è molta poca chiarezza sui temi che influenzano gli obiettivi che dovremmo raggiungere. Si vedano ad esempio i risultati di questi sondaggi, che mostrano come ci sia parecchio disaccordo rispettivamente sugli scenari di rischi esistenziali derivanti dalle IA e sul numero di questi rischi.

- Impatto indiretto:

- Field-building: avere un’idea precisa di ciò che si sta cercando di raggiungere e della sua importanza sarebbe utile per attrarre nuovi ricercatori in quel campo.

- Comunicare la necessità di nuove normative: se l’obiettivo è convincere le persone a prendere decisioni costose o drammatiche in futuro, è meglio sapere con esattezza cosa dire a proposito degli obiettivi che si sta cercando di raggiungere e della loro importanza.

Chi ci sta lavorando?

Alcune persone nelle seguenti organizzazioni: FHI, GovAI, CSER, DeepMind, OpenAI, GCRI, CLR, Rethink Priorities, OpenPhil, CSET,[4] oltre ad alcuni accademici indipendenti.

Ricerca tattica

L’obiettivo della ricerca tattica lungoterminista sulle IA è quello di individuare i programmi utili a raggiungere obiettivi di alto livello (a cui la ricerca strategica ha assegnato la priorità). Di solito la sua portata è più limitata per natura.

Vale la pena notare che può essere conveniente fare ricerca tattica anche se non si sono individuati con precisione degli obiettivi prioritari: per ricerca personale, per la propria carriera e per creare un campo di ricerca.

Esempi

- Windfall Clause

- Il programma: sviluppare uno strumento per la redistribuzione dei vantaggi delle IA per il bene comune

- Obiettivi di alto livello di questo programma: fare in modo che i protagonisti di questa ricerca non competano gli uni con gli altri per sviluppare per primi un’IA avanzata; ridurre la disparità economica.

- Meccanismi di sostegno di affermazioni verificabili

- Il programma: sviluppare pratiche con cui gli sviluppatori di IA possono rendere più verificabili le loro affermazioni riguardo lo sviluppo delle IA (affermazioni di cui gli sviluppatori possano essere ritenuti responsabili)

- Obiettivi di alto livello di questo programma: sviluppare meccanismi con cui è possibile dimostrare i comportamenti responsabili delle intelligenze artificiali; permettere un controllo più efficace; ridurre la tentazione di prendere scorciatoie per ottenere un vantaggio competitivo.

- IA e Antitrust

- Il programma: proporre modi per ridurre le tensioni tra le leggi antitrust e la necessità di uno sviluppo in cooperazione delle IA

- Obiettivi di alto livello di questo programma: aumentare il livello di cooperazione tra le società che sviluppano IA avanzate.

Storie di impatto

- Impatto diretto: creare soluzioni che vengano utilizzate per prendere decisioni migliori (nelle normative e nelle ricerche future).

- Quello che Allan Dafoe chiama "modello prodotto di ricerca".

- Impatto indiretto: anche se non tutte le soluzioni verranno usate per prendere decisioni migliori, saranno utili per la crescita del gruppo di persone che hanno a cuore i problemi della governance lungoterminista delle IA, oltre a migliorare le conoscenze, le competenze, le connessioni e la credibilità dei ricercatori.

- Quello che Allan Dafoe chiama "Modello di field-building della ricerca".

Chi ci sta lavorando?

Alcune persone nelle seguenti organizzazioni: FHI, GovAI, CSER, DeepMind, OpenAI, GCRI, CSET, Rethink Priorities, LPP, oltre ad alcuni accademici indipendenti.

Sviluppo, sostegno e attuazione delle politiche

La ricerca strategica produce obiettivi di alto livello. La ricerca tattica prende quegli obiettivi e produce dei programmi con cui raggiungerli. Lo sviluppo di politiche prende quei programmi e li trasforma in consigli pronti per essere consegnati ai decisori politici. Per fare ciò è necessario avere ben chiaro (ad esempio) quali domande fare di preciso, che tipo di linguaggio usare (sia nelle politiche formali che nella richiesta) e altre caratteristiche legate al contesto che influiranno sulle probabilità di successo.

Il sostegno alle politiche spinge affinché quelle politiche vengano attuate, ad esempio quali sono le persone più adatte per proporle, a chi e in quale momento.

L’attuazione delle politiche consiste nel mettere in pratica quelle politiche grazie al lavoro di impiegati statali o corporazioni.

È bene distinguere tra le politiche governative (ovvero quelle politiche pensate per essere attuate da governi od organizzazioni intergovernative) e le politiche aziendali (ovvero le politiche pensate per essere adottate dalle compagnie). Alcune persone che lavorano nel campo della governance lungoterminista delle IA si concentrano sul migliorare le politiche aziendali (in particolar modo quelle che riguardano gli sviluppatori di IA), mentre altri si concentrano nel migliorare quelle dei governi di pertinenza.

Un fattore motivante comune è che le specifiche del processo di attuazione sono spesso considerate fondamentali per il successo della stessa attuazione. Ad esempio, se una norma governativa presenta una falla, l’intera norma potrebbe essere inutile.

Rispetto alla ricerca, questo tipo di lavoro di solito si basa meno sui ragionamenti individuali e più sulla raccolta di informazioni/conversazioni (ad esempio riunioni per stabilire chi ha autorità su una determinata norma, cosa gli sta a cuore e quali sono gli interessi di altre figure rilevanti) e sul coordinamento (ad esempio stabilire in che modo convincere un determinato gruppo di persone a sostenere una data norma).

Come detto in precedenza, la conoscenza profonda a volte scorre "all’indietro". Ad esempio, la formulazione di una precisa politica potrebbe essere ripetuta in base a come il sostegno datole modifica le proprie conoscenze (e l’ambiente in cui ci si muove).

Esempi

- Politiche governative:

- Impegnarsi a non incorporare intelligenze artificiali nel comando, controllo e comunicazione in ambito nucleare (NC3), raccomandato ad esempio dal CLTR in Future Proof.

- Monitoraggio dello sviluppo di intelligenze artificiali da parte del governo, come elaborato in questo libro bianco sul monitoraggio delle IA.

- Fare in modo che nuove norme o strategie/principi sulle IA siano sensibili ai rischi derivanti da intelligenze artificiali avanzate (oltre che quelle attuali), come il feedback fornito da diverse organizzazioni AE sulla proposta di legge dell’UE sulle intelligenze artificiali.

- Politiche aziendali:

- Sviluppare norme per la distribuzione responsabile delle ricerche sulle IA, considerati i possibili usi impropri, come queste raccomandazioni del PAI.

La posizione di queste idee sullo spettro va da quelle più mirate (come ad esempio non integrare le IA all’interno dell’NC3) a quelle più generali (nel senso di creare una capacità generale per far fronte a un’ampia gamma di problemi che potrebbero sorgere, ad esempio la maggior parte di quelli visti in precedenza). Sono dell’opinione che allo stato attuale le nostre pratiche di sviluppo, sostegno e attuazione delle politiche debbano concentrarsi soprattutto sulle idee più generali, considerati tutti i dubbi sul futuro delle IA (e al tempo stesso spingere per l’attuazione di buone idee mirate quando se ne presenta l’occasione).

Storie d'impatto

- Impatto diretto: poter disporre di buone norme aumenta le probabilità di farsi strada con successo nella transizione verso un mondo con IA avanzate.

- Impatto indiretto: anche se non si è sicuri della robustezza di certe idee, svilupparle/sostenerle/attuarle permetterà a chi si occupa di governance lungoterminista delle IA di ottenere conoscenze, competenze, connessioni e credibilità. Non vogliamo arrivare a un "crunch time" dell'IA[5] e solo allora iniziare a capire come sviluppare politiche e processi decisionali.

- Detto questo, dovremmo anche fare molta attenzione a non attuare politiche che potrebbero rivelarsi dannose, ad esempio limitando lo sviluppo di politiche future.

Chi ci sta lavorando?

- Sviluppo:

- Sostegno:

- Attuazione:

Field-building

L’obiettivo dichiarato di questo lavoro è creare un campo o una comunità di persone che svolgano lavoro di una certa importanza nell’ambito della governance lungoterminista delle IA.[6] Possiamo vederlo come un lavoro in cui è necessario sia (1) coinvolgere persone nuove e (2) rendere questo campo più efficace.

Esempi

- Coinvolgere nuove persone creando:

- borse di studio, come la OpenPhil Technology Policy Fellowship;

- programmi o corsi online che aiutino i novizi ad aggiornarsi sulle ultime novità nel campo della governance delle IA;

- materiali introduttivi di ampio respiro e di alta qualità pensati per gli studenti universitari;

- finanziamenti di ricerca più scalabili per connettersi, sostenere e dare credibilità alle nuove leve.

- Rende questo campo più efficace creando:

- programmi di ricerca;

- opportunità per i ricercatori di lunga data di assumere facilmente assistenti di ricerca.[7]

Storie d'impatto

- Modello di crescita: creare un campo di ricerca sulla governance lungoterminista delle IA con molte persone allineate con le competenze e capacità giuste per condurre ricerche importanti e lavoro di policy (soprattutto quando questo tipo di lavoro è meno limitato da una mancanza di chiarezza strategica).

- Modello Metropoli:[8] creare un campo di ricerca sulla governance lungoterminista delle IA che abbia connessioni solide con comunità più grandi (ad esempio policymaking, scienze sociali, machine learning), in modo che questo campo possa contare sulle diverse competenze di queste comunità.

Chi ci sta lavorando?

GovAI, OpenPhil, SERI, CERI, CHERI e EA Cambridge. Più in generale, tutti i movimenti interni all’Altruismo Efficace che si occupano di cause generali. Tra tutti i tipi di interventi discussi in questo post, questo è quello meno considerato.

Ulteriori punti di vista sulla governance lungoterminista delle IA

Finora mi sono limitato a presentare un unico punto di vista della governance lungoterminista delle IA. Ovviamente ce ne sono altri, che potrebbero essere più utili per altri scopi. Ad esempio, si potrebbe dividere il panorama attuale in base ai diversi tipi di intervento:

- Intervenire sugli attuali dibattiti nell’ambito delle policy per far sì che siano più sensibili ai rischi esistenziali derivanti dalle IA (ad esempio maggiore consapevolezza di quanto può essere difficile creare intelligenze artificiali all’avanguardia)

- Proporre nuovi strumenti di policy (ad esempio, standard internazionali per le IA)

- Convincere i governi a finanziare la ricerca sulla sicurezza delle IA

- Portare a cambiamenti in ambito aziendale (Windfall Clause)

- ...

Oppure lo si potrebbe dividere in base all’area geografica (anche se non tutte le organizzazioni fanno parte di una determinata area):

- San Francisco Bay Area: OpenPhil, OpenAI, PAI, diverse organizzazioni che lavorano all’allineamento delle IA. Generalmente più concentrate sul non-allineamento come fonte di possibili rischi esistenziali; simili per cultura alla Silicon Valley e alle comunità razionaliste.

- Washington DC: il governo statunitense, CSET. Si concentrano sullo sviluppo/sostegno/attuazione di politiche statunitensi; simili per cultura alla cultura di DC.

- Regno Unito: FHI/GovAI, DeepMind, governo britannico, CSER, CLTR, (altre?). Di solito più concentrate sulle molteplici fonti di rischio esistenziale derivante dalle IA.

- Unione Europea: nel 2020 la Commissione Europea ha stilato la bozza della prima normativa sulle intelligenze artificiali del mondo, che con ogni probabilità verrà approvata nei prossimi anni e potrebbe generare un "effetto Bruxelles".

- Cina.

- …

Oppure, si potrebbe dividere in base a diverse "teorie di vittoria", vale a dire storie su come l’umanità giungerà con successo a un mondo con IA avanzate. C'è molto altro che si potrebbe dire sull’argomento. Lo scopo di questo post era solo quello di fornire una breve panoramica dei diversi lavori attualmente in corso.

Ringraziamenti: questo post è il risultato di una mia sintesi personale del panorama attuale, ma si ispira e/o estrapola direttamente da altri post sul forum di Altruismo Efficace di Allan Dafoe, Luke Muehlhauser, Convergence Analysis. Grazie anche a Jess Whittlestone per le preziose conversazioni, a Matthijs Maas, Yun Gu, Konstantin Pilz, Caroline Baumöhl e soprattutto a un critico del SERI per il feedback ricevuto sulla prima bozza.

- ^

Sicuramente ho dimenticato qualche gruppo importante e potrei aver sbagliato a classificarli o anche averli rappresentati male – se è così, fatemelo presente e correggerò!

- ^

Preso direttamente dalla definizione data da Open Philanthropy.

- ^

N.B.: alcune di queste domande riguardano la ricerca tattica piuttosto che quella strategica.

- ^

CSET si occupa perlopiù di ricerca tattica e sviluppo e sostegno di politiche, ma il loro lavoro nel mappare il processo di produzione dei semiconduttori rientra nella ricerca strategica.

- ^

Muehlhauser lo definisce "un periodo compreso tra 1 e 20 anni in cui potrebbero essere prese le decisioni più d'impatto sulle TAI".

- ^

Distinto dai vantaggi di field-building degli altri tipi di lavoro esaminati perché questo è esplicitamente e unicamente concentrato sulla creazione di un campo di ricerca.

- ^

Che potrebbe a sua volta aiutare a coinvolgere persone nuove.

- ^

Idea estrapolata da questo post di Allan Dafoe.