This is a Japanese translation of “The case for reducing existential risks”

By Benjamin Todd · Published October 2017 · Last updated June 2022

ベンジャミン・トッド著・2017年10月公開・2022年6月更新 [1]

1939年、アインシュタインはルーズベルト宛に次の手紙を書いた。1

「大量のウランに核連鎖反応を引き起こすことが可能かもしれません…また確信は全然ありませんが、それにより新型の、非常に強力な爆弾を作成することも考えられます。」

ほんの数年後、その爆弾が産みだされた。それから十年弱で歴史上はじめて、意思決定権をもつ一握りの人びとが文明を破壊できるようになるくらいには十分な数が製造されてきた。

人類は自然環境に由来する存亡リスク2だけではなく、自らを絶滅させることができるという可能性にも直面する新たな時代に到達してしまったのだ。

この新たな時代、我々の文明にとっての最大の優先課題は何であるべきか。テクノロジーを改善することか。貧しい人々を助けることか。政治システムを変えることか。

余り頻繁には論じられない提案はこうだ。すなわち、我々の最優先課題は生き残る(survive)ことであるべきだ、というものだ。

文明が存在し続ける限り、その他の問題をすべて解決する機会もあるだろうし、今よりも遥かにいい未来が待っているだろう。しかしもし我々が絶滅するなら、それで終わりだ。

この優先課題はなぜもっと議論されないのだろうか。その理由のひとつはこうだ。多くの人々は状況が変わっていることをまだ理解しておらず、そのため、我々の未来が危険に曝されているとは考えないのだ。

社会科学の研究者であるスペンサー・グリーンバーグ(Spencer Greenberg)は50年以内に人類が絶滅する可能性について、アメリカ人が抱いている見積もりを調査した。その結果明らかになったのは、多くのアメリカ人が、人類滅亡のリスクは極めて低いと考えており、30%以上の回答者が、1,000万分の1以下の確率だろうと推測していたことだ。3

我々も以前は人類滅亡のリスクは極めて低いと考えていた。しかしよくよく調べてみると、考えが変わった。これから見ていくように、この問題を研究する研究者たちは、人類滅亡のリスクは〔1000万分の1よりも〕1,000倍以上高く、そしておそらくそのリスクは増加し続けていると考えている。

こうした関心から、文明を保護する新たな運動が始まっており、この運動にはスティーブン・ホーキングやマックス・テグマーク(Max Tegmark)、そしてケンブリッジ大学、マサチューセッツ工科大学、オクスフォード大学やその他大学の研究者たちが設立した新たな研究機関が加勢してきた。

この記事の残りの部分では、文明に対する最大級のリスクを取り上げる。それには、核戦争や気候変動よりも大きいものとなりうるリスクがいくつか含まれる。それから、こうしたリスクを低減することが、あなたの人生で最も重要なことかもしれないと論じ、そのためにあなたにできることを詳しく説明する。もしあなたが自分のキャリアを使ってこの問題に取り組みたいなら、1対1のサポートを提供することも可能だ。

読み終えるまでの時間 25分

小惑星の衝突によって死ぬ確率はどれほどか?自然発生する人類存亡の脅威に関する概観

次の50年間における絶滅の可能性は1,000万分の1だというのは ──これこそ多くの人びとが考える値だが──低く見積もられているに違いない。自然発生する人類存亡への脅威は、これまでの歴史から、かなりの程度正確に推定することができ、かつ〔1,000万分の1よりも〕ずっと高いと推定されている。

地球に直径1キロメートルの小惑星が衝突したとしたら、文明が破壊される可能性がある。歴史的な記録を読み解き、天体を追跡することで、天文学者たちは、このサイズの小惑星が地球に衝突するリスクは一世紀毎に約5,000分の1であるとの推定を出すことができる。4 これはほとんどの人にとって、飛行機事故に遭遇する確率(一回のフライト毎に約500万分の1)よりも高く、1,000万分の1という一部の人びとの見積もりよりも既に約1,000倍高い。5

一部の論者は、直径1キロメートルの物体は大惨事ではあろうが、絶滅を引き起こすほどではないだろうから、前述の値は当のリスクを高く見積もっていると論じている。しかし他方で、自然に起こるものとしては、破局噴火(supervolcano)などの他のリスクも存在する。6

とはいえ、自然由来のリスクは絶対評価ではかなり低い。トビー・オード(Toby Ord)博士がもうじき出版する論文は、自然リスクをすべて足し合わせても、一世紀あたり300分の1の確率以上になることはありそうにないと見積もっている。7

しかし以下で見ていくように、残念ながら自然リスクは人間が原因となっているリスクに比べたら遥かに小さい。そして、だからこそ、存亡リスクが格別、切迫した問題となるわけだ。

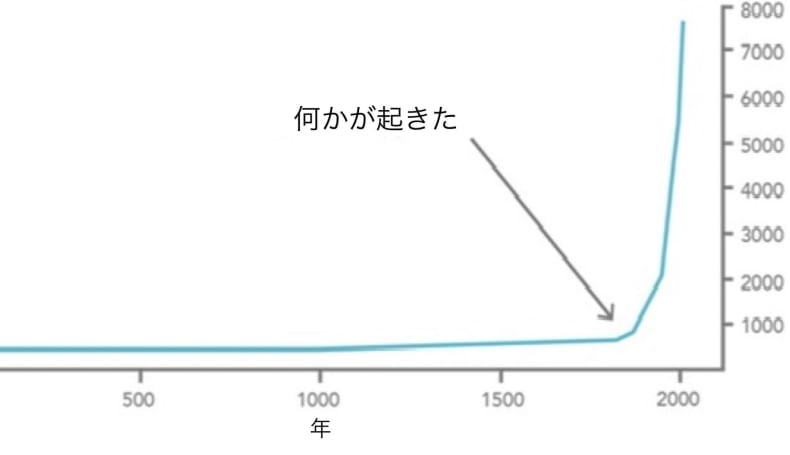

人類史上最も危険な時代の幕開けに至るまでの進歩の歴史

2000年の歴史を見渡すなら、基本的なメッセージはこうだ。長い間、ほとんどすべてのひとが貧しかったが、18世紀になってから状況は変化した。8

この変化は産業革命によるものだ。産業革命はもしかすると、歴史上最も重要な出来事かもしれない。

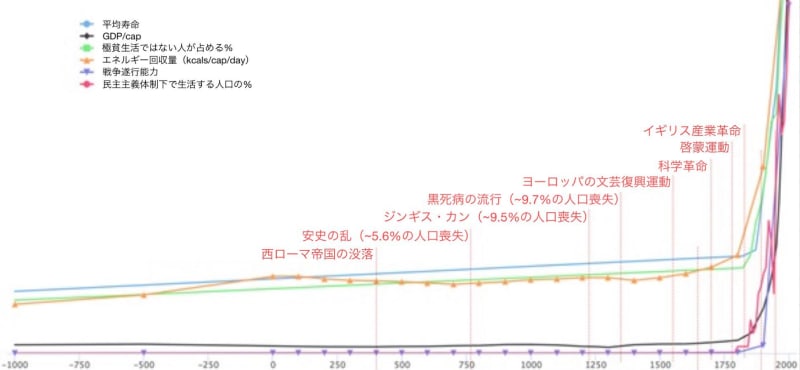

増えたのは富だけではない。次のチャートが示しているのは、長期間にわたって、平均寿命、エネルギーの使用量、民主主義のすべてが急速に発達し、貧困層の割合も劇的に減少してきたことである。9

2017年Luke Muehlhauser作成のチャート

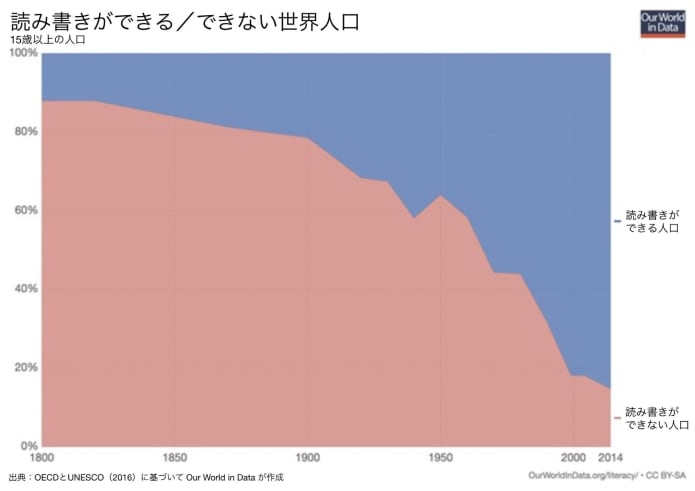

識字率と教育水準も劇的に増加してきた。

出典:OECDとUNESCO(2016)に基づいて Our World in Data が作成

人びとは豊かになるにつれてより幸福になっているようにも思われる。

『暴力の人類史』(原題:The Better Angels of Our Nature)の中でスティーブン・ピンカーは、暴力は減り続けていくと論じている。10

個人の自由が増大してきた一方で、人種差別、性差別、同性愛嫌悪は減少してきた。

多くの人々が、世界はどんどん悪い方向に進んでいると考えており、11 確かに現代文明は工場式畜産のような惨いこともしている。しかしデータから見て取れるように、進歩を測る重要な指標の多くが劇的に改善してきてもいるのだ。

さらに重要なのは、過去がどうあれ将来を見据えたときに、テクノロジー、政治組織や自由を向上することは、現代我々が直面する問題を解決し、大幅に改善した生を享受する可能性を子孫に受け渡すことになる。12 貧困を撲滅し、気候変動を防ぎ、苦しみを減らし、さらにはそれ以上のことをすることも可能である。

しかしふたつ目のチャートの、戦争遂行能力を示す紫色の線に注意を向けて見てほしい。これは、歴史学者イアン・モリスの推定に基づくが、世界中の軍事力は劇的に増加している。

問題はここにある。テクノロジーを発展させるなら、途方もない利益を得る可能性だけではなく、途方もないリスクも背負い込むことになるのだ。

新しいテクノロジーを発見するたびに、ほとんどの場合、それは巨大な利益を生みだす。しかし我々が賢く使う能力をもつ以上に破壊的な力をもつテクノロジーを発見する可能性もある。

それだからこそ、現世代は人類史上最も繫栄した生活を送っていながら、最も危険な世代でもあるわけだ。

この種の破壊的なテクノロジーの最初のものが核兵器だった。

核兵器 ── 度重なるニアミスの歴史

こんにちの我々には、北朝鮮の核兵器開発計画が頭をよぎる。しかし現在起きていることは、度重なるニアミス事例からなる長い物語の一章に過ぎない。

キューバ危機の間だけでも危うく核戦争に突入しかけたことが何度かあった。13 ひとつの事例では、アメリカ人たちは彼らのスパイが乗った飛行機が撃ち落された場合、追加の軍事評議会なしに、すぐさまキューバを侵略すると決議した。次の日、ひとりのスパイが乗った飛行機が撃ち落された。ジョン・F・ケネディはそれでもともかく評議会を招集し、侵略を踏みとどめた。

キューバへの侵略は核戦争の引き金となっていたかもしれない。カストロは「キューバが完全に消失することになっても」、核による報復を選ぶことに賛成していたことが後で明らかになっている。キューバのロケット発射指揮者の一部も、侵略が起きた場合、米軍を標的に戦略核兵器を使用する独立した権限を持っていた。

また、ロシアの原子力潜水艦がキューバに資材を密輸しようとしていたところを、アメリカの艦隊に発見された事件もある。アメリカの艦隊は、潜水艦を浮上させるため、ダミーの爆雷を投下し始めた。ロシアの艦長は、それが本物の爆雷であり、無線が通じない中、第三次世界大戦が始まったと考えた。彼は、アメリカ艦隊に核魚雷による攻撃を命じた。

幸運なことに、艦長には他の上官からの承認が必要だった。そのうちの一人、ヴァシーリイ・アルヒーポフが同意しなかったために、戦争は避けられた。

ヴァシーリイ・アルヒーポフさん、その節はどうもありがとう。

こうした出来事を総合して、ジョン・F・ケネディは後に、核戦争の確率は「三分の一かそれ以上」であったと見積もった。14冷戦後でさえも、ロシアと際どいところまでいった例には事欠かない。ウィキペディアのこちらのいい感じの記事にリスト化されている通りである。しかもこれらは、我々にとって既知の事例に過ぎない。

現代の核の専門家は、共に核兵器を所有しているインドとパキスタンのあいだの緊張にも北朝鮮と同じくらいに神経をとがらせている。15

重要な問題は、直ちに展開できるような大規模な核兵器庫を保持する国がいくつも存在することだ。そのため、誤報や事故が、特に外交関係が緊張しているときには、本格的な核戦争へと急速に発展してしまう可能性がある。

核兵器が文明を終わらせることはあるだろうか。当初は、核爆発による暴風があまりに高温であるため、大気を燃焼させ地球を生息不可能にしてしまうだろうと考えられていた。科学者たちは、これはあまり起こりそうになく、核兵器を「安全に」テストすることはできると推定しており、現在の我々は、そのようなことは起こらないだろうと知っている。

1980年代には〈建造物の炎上が生みだす灰により、地球は、穀物が何十年も成長することのできない、長い冬に突入することになる〉という懸念があった。16 現代の気候モデルは、「核の冬」が全人類の生命を奪うほど深刻なものとなることはとてもありそうにないと示唆しているが、モデルの不確定性があるために確信を持つのは難しい。17

しかし、もう少し「穏やかな」核の冬であっても大飢饉を引き起こす可能性がある。18その他の理由と合わせて、核戦争が起これば、それは世界を極端に不安定化させるものであるだろうし、そうなれば文明が復帰できるのかどうかも明らかでない。

核戦争が人類文明を永久に終わらせてしまう可能性はどれくらいあるだろうか。これを推定するのは極めて困難だが次の世紀に文明を終焉にもたらす核戦争が起こる確率は0.3%を超えないと結論するのは難しそうだ。これは、核兵器によるリスクが、自然リスクをすべて合わせたものよりも大きいことを意味する。(核のリスクについてもっと詳しく読む)

これこそ1950年代が人類の新しい時代の幕開けであった理由だ。史上はじめて、少数の意思決定者が世界全体に大惨事をもたらすことも可能になったのだ。こんにちの我々は、自分自身の生存に最大の脅威を与えている。そしてこのことが、この時代を歴史上最も危険な地点にしているのだ。

そのうえ核兵器は、文明を終わらせる唯一の方法ではない。

気候変動のリスクはどれほどか?

2015年、オバマ大統領は一般教書演説の中で「気候変動は我々にとって最大の脅威」だと述べていた。

気候変動は確かに、文明に対する大きなリスクである。

最もありえそうな結果は2-4度の温暖化だ。19 これは確かに良くない結果だが、我々人類にとっては生き抜ける程度のものだ。

しかし一部の推定によれば、6度以上温暖化する確率は10%あり、9度の温暖化の確率は1%ある。

したがって、二酸化炭素が産み出す大規模な気候災害が起こる確率はおそらく、核戦争が起こる確率と似たものになるように思われる。

しかし、気候変動問題の外郭で論じたように、13度の温暖化でもそれが直接、人類滅亡の原因になるということはなさそうだ。そのため、こうした問題を研究する研究者たちは、核の冬の可能性があるため、核戦争は気候変動よりも即座の人類滅亡につながりそうだと考える。これが、核兵器は気候変動よりも大きなリスクを投げかけていると考える理由である。

とはいえ、気候変動は確かに大きな問題であり、世界を不安定化するその影響によって(核紛争のリスクも含めて)他のリスクを悪化させることがありうる。このことは、これらのリスクの見積もりを更に高めるはずだ。

どんな新たなテクノロジーが、核兵器と同じくらい危険なものとなりうるか?

核兵器の発明は、そのたったの二、三十年後の1960年代には反核運動へとつながった。そして環境保護運動が気候変動に取り組むという課題を掲げるのにも時間はかからなかった。

あまり認知されていないのは、新しいテクノロジーがさらなる存亡リスク[2]を提起していることだ。だからこそ文明全般の保護に携わる運動が必要になる。

未来のテクノロジーを予期するのは難しい。しかし我々が手にしている文明はひとつしかないのだから、最善を尽くす必要はある。以下が、次世代のテクノロジーのうち、核兵器と同じくらい危険となりうるものである。

人工パンデミック

1918-1919年、世界人口の3%以上がスペイン風邪のために亡くなった。20 そのようなパンデミックが今発生しようものなら、地球全体で輸送交通手段が発展しているために、事態はより深刻なものとなるかもしれない。

とはいえより気がかりなのは、スペイン風邪と同じくらい感染しやすいにもかかわらず、より致死率が高く、かつ何年にも渡り検知さないまま広がる可能性のあるウィルスを遺伝工学的に作成することがすぐにでも可能になってしまうかもしれないことだ。

それは核兵器のような破壊的な能力を備えたものとなるだろうが、その使用を防ぐのは核兵器よりもずっと困難だ。核兵器は、それを作るには巨大な工場と、希少な物質を必要とするため、コントロールするのは比較的簡単だ。対してデザイナー・ウィルスであれば、生物学の博士号をもつ数人が実験室内で作成することができる。実際、2006年に『ガーディアン』紙は、絶滅した天然痘ウイルスを郵送で受け取ることができた。21一部のテロリスト集団は、そのような無差別兵器を使用することに関心があることを表明してきた。(詳しくは、こちらの記事を参照)

人工知能

大きなポテンシャルを秘めたもうひとつのテクノロジーは、人工知能だ。

世界の主導権を握っているのは人間であって、チンパンジーではないのは、純粋に知性の問題だ。身体的にはチンパンジーより遥かに劣るという事実にもかかわらず、大きく強力な脳をもつことで我々は、世界を統制する驚くほどの能力をもっている。

では、いつか我々が、自分たちよりもずっと優れた知性をもつものを創りだしたとしたら、何が起こるだろうか。

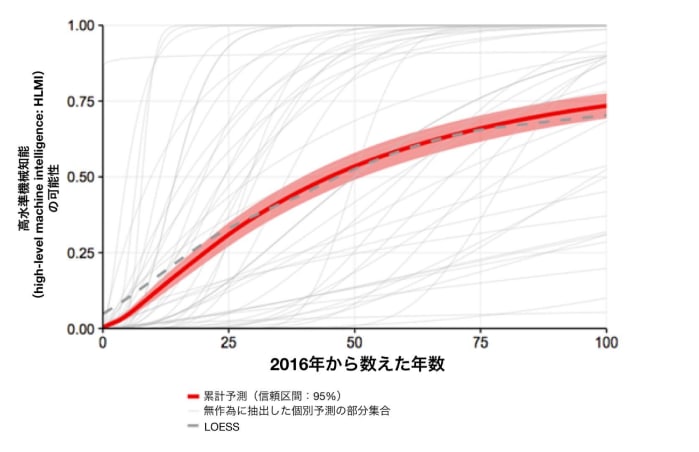

2017年、この分野のトップの学会で、人工知能に関する査読済みの研究を公刊した350人の研究者たちを対象に、アンケートが実施された。そのアンケートで研究者たちには、人間と同じレベルの知性をもつコンピュータ、すなわち、あらゆる課題で人間よりも優れたタスクをこなすことのできる機械が開発される時期について尋ねられた。

中央値の見積もりはこうだ。45年以内に高いレベルの機械知能を開発する確率は50%であり、この世紀の終わりであれば75%の確率である。22

こうした確率は見積もるのが難しいし、研究者たちも、どう質問するかによってかなり異なる値を回答する。23 それでも少なくとも、何らかの種類の革新的な機械知能(transformative machine intelligence)が次の世紀に開発される確率は十分にある。さらに、不確実性が大きいということは、それが人びとが考えるよりも遅く来るというよりも、より早く訪れるかもしれないということでもある。

革新的な機械知能を開発することで、どんなリスクが生まれるだろうか。アラン・チューリングやマーヴィン・ミンスキーのような計算機の初期のパイオニアは、強力な計算システムのリスクに対する懸念を表明してきた。24 また、そうしたリスクはいまも変わらず存在している。コンピュータが「悪魔と化す」ことがここで問題となっているわけではない。むしろ懸念事項のひとつは、強力なAIシステムがある特定の集団によって世界を支配するために使われる、あるいは誤った仕方で使われる可能性があるという点にある。ソビエト連邦がアメリカよりも10年早く核兵器を開発していたとしたら、ソビエト連邦が世界の支配権を握っていたかもしれない。強力な計算機テクノロジーも似たようなリスクを生み出す。

もうひとつ別の懸念は、AIシステムの利用には意図せざる結果が伴うかもしれないことだ。というのは、自分たちよりも賢い存在の行動を予測するのは、人間の行動を予測するよりも難しいだろうからである。十分に強力なシステムであれば、既に制御が難しいだろうし、それがひとたび実装されれば実装前の状態に戻すのも困難かもしれない。これらの懸念は、オックスフォード大学教授、ニック・ボストローム(Nick Bostrom)の著作『スーパーインテリジェンス』やAIのパイオニアであるスチュアート・ラッセルによって論じられてきた。

ほとんどの専門家が、より優れたAIの開発は極めて良い結果をもたらすと考えつつ、リスクがあることも承知している。前述の調査のなかで、AIの専門家たちは、高いレベルの機械知能が「悪い結果」を招く確率は10%ほどあり、人類滅亡のような「極端に悪い」結果をもたらす確率は5%ほどあると推定している。22 さらに言えば、このサンプルには偏りがあるとも考えるべきだろう。なにしろ彼らはAIテクノロジーで生計を立てているのだ。

以上の推定を合算すると、次の世紀に高いレベルの機械知能が開発される確率が75%あるとすると、 AIによる大災害が起こる確率は75%のうちの5%、つまり約4%あることになる。(人工知能のリスクについて詳しくはこちらの記事を参照)

新興テクノロジーに由来する他のリスク

地球工学や原子加工(atomic manufacturing)[3]といった他の形態の新たなテクノロジーにも懸念が持ち上がっている。しかしそうしたテクノロジーはそれほど切迫した問題ではなく、これまで見てきた他のテクノロジーよりも危険ではないと広く理解されている。存亡リスクの長いリストはこちらで見ることができる。

おそらくそれ以上に気がかりなのは、我々が考えたこともないリスクである。1900年に生きていた人びとに、文明に対する最大のリスクは何かと尋ねても、核兵器や遺伝子工学、人工知能を挙げることはおそらくなかっただろう。というのもそうしたテクノロジーはまだ発明されていなかったのだから。次の世紀に目を向けたとき、我々が同じ状況にいるというのはありうる。将来の「知らないと知らないこと(unknown unknowns)」は、こんにち我々が知るよりも大きなリスクを投げかけるかもしれない。

新しいテクノロジーを発見することは、発見するそのたびに、ルーレットのひとつの数字以外のすべての数字に賭けるのと少し似ている。ほとんどの場合には我々が賭けに勝ち、そのテクノロジーはおしなべてよいものだ。しかしそのたびごとに、テクノロジーが私たちに扱える以上の破壊的な力を与え、我々がすべてを失うことになる僅かな確率も存在する。

我々が開発する新しいテクノロジーのひとつひとつが、未曾有の潜在能力と危険性の両方を兼ね備えている。画像の出典

すべてを合計すると人類滅亡の全リスクはどれほどか?

この問題を研究している多くの専門家が、次の世紀に人類が滅亡する確率の総計は1から20%の間だと推定している。

ウィル・マカスキルをゲストに招いた我々のポッドキャストでは、彼が今世紀に人類が滅亡するリスクを1%ほどだと見積もっている理由を説明している。

また、2020年の著作『絶壁──存亡リスクと人類の未来』(未邦訳、原題はThe Precipice: Existential Risk and the Future of Humanity)中でトビー・オードは、今世紀の存亡リスクの総計は、6分の1(つまり約17%)だとの推測を与えている。これはサイコロを振ってひとつの目が出る確率だ。(ただし、存亡的破局(existential catastrophe)に関するトビーの定義は、人類滅亡と全く等価なわけではない。存亡的破局には、例えば一部の人間が生き残っていたとしても、人類が再び元通りとなるまで回復することはできないような、世界規模の破局が含まれる。)トビーをゲストに迎えた回を聴く。

トビーの本には、彼の信じるところによれば上位に位置する脅威となる存亡リスクについて(極めて大まかな)見積もりを一覧にした次の表が載っている。

| 存亡的破局の原因 | 次の100年間で起きる確率 |

|---|---|

| 小惑星や彗星の衝突 | ~ 1/1,000,000 |

| 破局噴火 | ~ 1/10,000 |

| 恒星爆発 | ~ 1/1,000,000,000 |

| 自然リスクの総計 | ~ 1/10,000 |

| 核戦争 | ~ 1/1,000 |

| 気候変動 | ~ 1/1,000 |

| その他の環境破壊 | ~ 1/1,000 |

| 「自然に」発生するパンデミック | ~ 1/10,000 |

| 人工パンデミック | ~ 1/30 |

| AIの逸脱 | ~ 1/10 |

| 不測の人為的リスク | ~ 1/30 |

| 他の人為的リスク | ~ 1/50 |

| 人為的リスクの総計 | ~ 1/6 |

| 存亡リスクの総計 | ~ 1/6 |

これらの値は、人びとが通常考えるよりも約100万倍高い。

こうした見積もりから何を読み取るべきだろうか。もしかすると、この話題に関心をもつ研究者たちは、こうした問題が極めて重要だと考えるからこそ取り組んでいるのだろうから、その見積もりが(選択バイアスにより)高くなるということはあり得るだろう。こうした数値にはさらなる議論の余地はあるものの、マッカスキルやオードも含めて我々は、一定の範囲内の見解がもっともらしいと考えている。

未来を庇護することへの貢献が、あなたができる、人生で一番重要なことでありうる理由

世界的貧困や癌の撲滅、政治的変革のような他の問題と比べて、こうしたリスクを減らす仕事をどれくらい優先すべきだろうか。

80,000 Hoursでは、人びとがよい社会的インパクトをもったキャリアを見つけるのに役立つような研究を行っている。その一環として、この世界で取り組むべき最も切迫した問題を見つけ出そうとしている。当団体は、自前の問題フレームワークを使って様々な世界規模の問題を評価している。このフレームワークは以下の観点から様々な問題を比較するものである。

- 規模―どれくらい多くのものがその問題の影響を受けるのか。

- 見過ごされている度合い―その問題にすでに取り組んでいる人の数はどれほどか

- 解決可能性 ― 進捗を生むのがどれくらい簡単か

このフレームワークを適用するなら、未来を守ることは、この世界の最優先事項であることが明らかになる。また、もしあなたが、あなたのキャリアによって大きな、ポジティブなインパクトをもちたいなら、これは焦点を当てるべきトップの領域になる。

次の数節で我々は、この問題を、規模、見過ごされている度合い、解決可能性に基づいて評価する。その際、主には、私たち自身の研究と共に、ニック・ボストロームの「世界的優先課題としての存亡リスク予防」とトビー・オードの未公刊の著作に大いに依拠する予定である。

最初に、問題の規模から始めよう。次の世紀に滅亡する確率は3%を超えそうだと既に述べていた。これはどのくらい大きな問題なのか。

私たちが目を向けることのできるひとつの数字は、その破局によって亡くなる人数だ。この世紀の中ごろには地球の人口は約100億人となるだろう。そのため、全員が死んでしまう確率が3%であるということは、死者数の期待値が約300万人であるということだ。これはおそらく、次の世紀に、マラリアのような貧困の病気(diseases of poverty)を原因とする死者数として予測できる数を超えている。25

これまでに取り上げてきたリスクの多くは、文明を終わらせるものというよりは「中間クラスの」破局を引き起こすこともありうる。しかもこれは極めて確からしいだろう。我々が以前に取り上げた研究では、次の世紀に10億人以上の人びとの命を奪う破局の確率は10%を超えると示唆していたが、これは少なくとも期待値として1億人の死者数を追加することになるし、生存した者にも遥かに多くの苦しみを残すことになる。

したがって、私たちが現世代へのインパクトだけに焦点を当てる場合も、こうした破局リスクは、人類が直面する最も深刻な問題のひとつである。

しかし以上の考察は問題の規模をかなり低く見積もっている。というのも文明が終わるなら、私たちは自分たちの未来そのものを失うことになるからだ。

ほとんどの人びとは、自分の孫たちによりよい世界を残したいと望んでおり、そのなかでもほとんどの人びとは、より広く、将来世代への関心を持つべきだと考えている。こんにち生きている人びとよりもずっと多くの人々が未来には、素晴らしい生を送っているかもしれないわけで、私たちは彼らの利害にもいくらか関心をもつべきだ。人類の文明が何百万年も続く可能性はある。それゆえ、将来世代への様々なリスクがもつインパクトを考えるなら、賭け金は ──善かれ悪しかれ ── 数百万倍高い。カール・セイガンは雑誌「フォーリン・アフェアーズ」の中で、核戦争の費用について次のように書いていた。

核戦争は、人類が続く限り子孫全員を危険にさらすことになる。成功した種の生物学的進化にかかる典型的な時間(大体100万年)に渡って、人口が一定のまま、平均寿命が100年のオーダーであるとしても、さらに500兆人ほどが俎上に上る。この規準によれば、賭け金は、「たったの」数百万人を殺害するだけの、より穏当な核戦争のそれよりも、100万倍大きい。文化や科学、この惑星の発展史、その子孫の未来のために貢献してきた我々の祖先皆の人生の意義など、潜在的な損失を測るその他の可能な指標も多く存在する。人類滅亡は人類のこれまでの企てを白紙に戻すことだ。ローマ人が人類を滅亡させなくてよかった。現代のすべての文明はそのおかげで存在することができてきたのだから。私たちの後に来る人びとが、充実した生を送るだろうと想定すれば(実際にそうなると我々は信じてもいるが)、彼らにも似たような責任を我々は負っていると考える。短期的に自分たちさえうまくいくように取り計らうために将来世代を存亡の危機にさらすのは思慮を欠く振る舞いであり、公正さを欠くことでもあるだろう。

未来にはもっとたくさんの人間がいるだろうというだけではない。セーガンも指摘していたように、価値についてどう考えようとも、未来には遥かにたくさんの価値が存在する可能性がある。将来の文明は、あらゆるニーズと欲求が満たされる世界を創りあげているかもしれないし、想像を絶する知的・美的成果を残しているかもしれない。いまよりもずっと公正で、有徳な社会を形成しているかもしれない。そしてまた、我々の銀河に千億と存在する他の惑星に文明が到達しないと考える原理的な理由もない。26 もし我々が文明を終わらせてしまうなら、このどれも起こりえないことになってしまうのだ。

この輝かしい未来が本当にやってくるのかどうかは不確かだが、それもまた、文明を存続させ、その答えを見つけ出すさらなる理由になる。ともしびを次世代に渡し損ねるのは、我々がしでかせるなかでは最悪のものだ。

それゆえ、文明が終焉する何パーセントかのリスクは、こんにちの世界が直面する最大の問題であるというのがもっともらしいように思われる。これもまた驚くべきことだが、こうしたリスクはかなりの程度、見過ごされている。

存亡が最も見過ごされた世界的な問題である理由

毎年、重要な課題領域に費やされている金額を一覧にしたのが次の表だ。27

| 課題領域 | 一年当たりに、あらゆる資金源から流れ込む資金の額(極めて概算的な額) |

|---|---|

| グローバルなR&D | 1.5兆ドル |

| 贅沢品 | 1.3兆ドル |

| 米国の社会福祉 | 9千億ドル |

| Climate change 気候変動 | >$300 billion 3千億ドル以上 |

| To the global poor 世界的貧困 | >$250 billion 2,500億ドル |

| Nuclear security 核の安全保障 | $1-10 billion 10-100億ドル |

| Extreme pandemic prevention 大規模パンデミックの予防 | $1 billion 10億ドル |

| AI safety research AIセーフティ研究 | $10 million 1,000万ドル |

この表にある通り、我々は途方もない量の資源をR&Dにつぎ込んで、さらに強力なテクノロジーを開発しようとしている。私たちはまた、贅沢品を買うことで、私たちの生活を向上させようという(おそらくは誤った)試みに多くを費やしている。

気候変動と比べて破局リスクの緩和に費やされている金額は遥かに少ない。気候変動に対する世界全体の支出は、米国だけの福祉支出と比べても小さい。

それでも気候変動は、私たちが取り上げてきた他のリスクのいくつかと比較すると、途方もない金額を受け取っている。大規模な世界的パンデミックの予防は、気候変動と同程度のリスクであるにもかかわらず、その300分の1以下の資金しか受け取っていない。

AIシステムの事故を避けるための研究は、あらゆるもののうちで最も見過ごされており、毎年1,000万ドルほどと、パンデミックの予防のさらに100分の1以下の資金しか受け取っていない。

投入された資金ではなく、こうしたリスクに取り組んでいる人数を見ても、似たような描像を得る。ただし資金を見た方が数値を得るのは簡単だ。

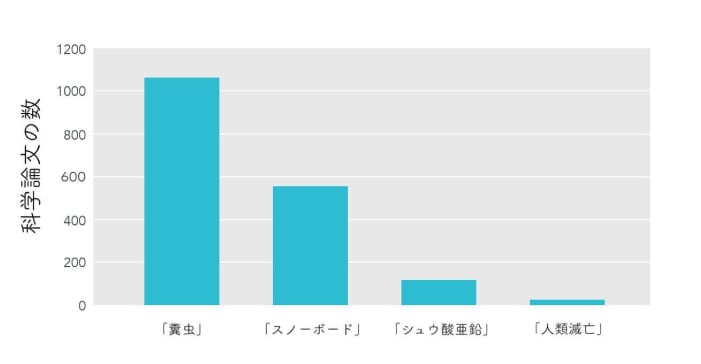

その代わり、科学界での注目度を見てみるなら、見過ごされている度合いについて同様に描像を得る(が、気候変動などの個々のリスクをみると、その一部は相当程度の注目を浴びている)。

Credit: Nick Bostrom

クレジット:ニック・ボストローム

政治的な注目度に目を向けるなら、助成金の金額について似たような描像を得るだろうというのが私たちの印象だ。圧倒的に多くの政治的な注意が、短期的な、現世代を助けるような具体的問題に流れ込んでいる。というのも、それこそ票を集めるものだからだ。破局リスクは遥かに見過ごされている。そして破局リスクのなかでも気候変動は最大の注目度を受けている一方で、パンデミックやAIのような問題は最も見過ごされている。

人的資源、科学研究、政治的注目度のどの観点からもこれほど見過ごされてしまうのは、根底にある経済的事情からまさしく予測されることだし、だからこそこの分野は、この世界をより良い場所にしたいと思う人びとにとっては、絶好の機会となる。

第一に、こういったリスクは、一国家の責任ではない。米国が気候変動を抑制するために重点的な投資を行ったとしよう。これは世界中の人間の利益になるが、米国で生きているのは世界全体の人口のほんの5%ほどでしかない。それゆえ米国市民がこの歳出により受け取るのは、その利益のうちの5%でしかない。つまり米国は気候変動を抑制しようという彼らの努力がこの世界に対してもつ価値にもかかわらず、こうした努力は驚くほどの過少投資になってしまっているのだ。そして同じことが、他のどの国にも当てはまる。

私たち全員が協力することができれば、この問題は解決する。すなわち、もしもすべての国家が気候変動を減らすため、公正な分担を引き受けることに同意するなら、気候変動による最悪の影響を回避することにより、全国家が利益を受けるだろう。

残念ながら個々の国家の視点から見ると、自国の排出量を抑制しないまま、他のすべての国家がその排出量を減らしてくれた方がいい。したがって、各国家には、気候変動抑制に関する協定から離脱するインセンティブが存在するのであり、だからこそこれほど僅かな進捗しかないのだ(これは囚人のジレンマのひとつである)。

そして実のところ以上は問題のほんの一部でしかない。破局リスクを減らす努力の最大の受益者は将来世代である。経済的であれ、政治的であれ、彼らが自分自身の利害のために立ち上がることはどうやってもできない。

もしも将来世代が我々の選挙で投票することができたなら、彼らは圧倒的に、より安全な政策に投票するだろう。同様に、もし将来世代が資金を過去に送り届けることができたなら、彼らは破局リスクを減らすことに巨額の資金を支払っていただろう。(要は、こうしたリスクを減らすと、世代を超えた、世界的な公共財を創造することになる。この点で、破局リスクの減少は、よいことを行う手段としては、もっとも見過ごされた手段のひとつとなる。)

現在の我々のシステムは、将来世代を保護するのにはお粗末な働きしかしていない。我々が知るなかには、英国の政府高官と直接話した人もいるし、またその多くが破局リスクに対して何かをしたいと望んでいるのだが、報道の圧力や選挙の周期がこの問題に焦点を当てることを難しくしている。ほとんどの国々では、破局リスクの緩和をその権限にもつ政府機関は存在しない。

以上は気が重くなる状況だが、チャンスでもある。この世界をよりよい場所にしたいと望む人びとにとっては、注目されていないということは、他者を助ける方法として、遥かに高いインパクトがあることを意味するからだ。

存亡リスクに対して何ができるか

存亡リスクの問題の規模と見過ごされている度合いを取り上げてきたが、我々のフレームワークの第三の要素、解決可能性はどうなのか。

存亡リスクの問題について、グローバル・ヘルスのような従来の問題以上に進捗を生めるかと言えば、〔これまで論じてきたふたつの要素よりも〕確信は少ない。健康に対する我々のインパクトを測るのは(少なくとも短期的には)ずっと簡単だし、うまくいく方法については何十年もの証拠の蓄積がある。つまり、解決可能性に関して言えば、破局リスクの削減への取り組みは分が悪いように見えるのだ。

しかしそれでも我々にはできることが沢山あって、存亡リスクの規模の大きさと見過ごされている度合いの高さを考慮するなら、この問題はなおも切迫した問題であるように思われるのだ。

以上の存亡リスクを減らすいくつかの方法を素描しよう。これは3つの広いカテゴリーに分かれる。

1. 特定のリスクの削減に狙いを定めた努力

ひとつのアプローチは、各リスクに直接取り組むことだ。それぞれのリスクに対処する具体的な提案はいくつも存在する。例えば

- 多くの専門家によれば、感染症発生動向調査体制を改善すれば、パンデミックのリスクを減らすことができる。これには、技術発展や、既存のデータの収集方法や蓄積方法を改善することにより、新しいパンデミックをより素早く特定することが含まれる。そして、新しいパンデミックをより素早く特定することができればできるほど、それを管理するのもより簡単になる。

- 優れた太陽光パネルを開発したり、炭素税の導入を支援するなどして、気候変動を緩和する方法は多々ある。

- AIについては、強力なAIシステムから意図せざる害を被る確率を減らすために、コンピュータサイエンスの分野で「コントロール問題」を研究することができる。最近の論文「AIセーフティの具体的諸問題」は、具体的な話題をいくつか素描しているが、今現在似たような研究にフルタイムで取り組んでいるのは20人程度しかいない。[4]

- 核の安全保障では、核兵器の抑止力はいまよりもずっと少ない備蓄量でも維持できると多くの専門家が考えている。しかも備蓄量が少なければ少ないほど、事故のリスクを減らし、例えば核戦争が起こったとしても、文明を終わらせてしまう確率も下げられる。

以下の記事では、我々が素描した問題のうちで、各リスクと闘うためにあなたにできることをより詳しく論じている。

この節では、自然を原因とするリスクに焦点を当てることはしない。というのも、自然を原因とするリスクはずっと低く、その一部について言えば、既に我々はかなりの量、取り組んでいるからだ。富を増大させ、テクノロジーを発展させることで、自然リスクへのレジリエンスを高めることができるだろうが、富を増やすことや、テクノロジーを発展させることには既に莫大な努力が注ぎこまれている。

2. リスクを減らすためのより広い視点に立った努力

各リスクを個別に減らすよりも、文明全体をそうしたリスクにうまく対処できるようなものへと変えようとすることも可能だ。この「広い視点に立った」努力は、我々が考えたこともないような脅威を全部、一挙に減らすことに貢献する。

例えば、破局リスクが生じたそのときに、そうしたリスクに対処する必要があるような、鍵となる意思決定者が政府の中にはいる。もしこうした人びとや機関の意思決定能力を改善することができるなら、社会全体が破局リスクに対するレジリエンスを高め、その他多くの問題を解決することができるようになるだろう。

最近の研究は、意思決定を改善するための多くの方法を明らかにしてきが、そのほとんどはまだ実装されていない。しかも、この問題に取り組んでいるのはほんの一握りの人間だ。これについては関連機関の意思決定の改善を取り上げた我々の記事でより詳しく論じている。

「広い視点に立った」努力のまた別の例として、より容易に、破局から立ち直ることができるような文明を形成することも考えられる。世界種子貯蔵庫は、北極の冷凍の貯蔵庫であり、重要な種が失われる可能性を減らそうと大量の重要な穀物種の種を蓄えている。皮肉なことに、最近、気候変動による影響で永久凍土から解けだした水が貯蔵庫に続くトンネルに入り込んでしまったため、追加の助成金を利用するかもしれない。知を保存するために我々ができるこの種のプロジェクトは他にも多々ある。

同様に、我々はより優れた防災シェルターを作ることもできる。これは、パンデミックや核の冬、小惑星による(ただしAIによるのではない)絶滅の確率を減らしつつ、災害後の復旧の確率も上昇させる。今現在、この手段は、最初から当のリスクを減らすよりも効果的であるようには思われないが、それでも助けにはなる。より見過ごされている、そしておそらく、それよりずっと安価な選択肢は、長い冬の間も、光もいらずに即座に量が増大しうるような、代替食糧源を創り出すことだ。

広い視点に立った努力は、リスクの詳細について不確かな場合でも有益であり、また確信がないほどより魅力的な選択となる。〔反対に〕当のリスクをより詳しく知るようになればなるほど、広い視点に立った努力から、狙いを定めた努力へと徐々につぎ込むリソースを分配し直すべきであるということになる。(より詳しくはこちら)

広い視点に立った介入策には、より見込みあるものも沢山あるとは思うが、これは、僅かな研究しか行われてこなかった分野だ。例えば、また別のアプローチとして、国際的な協調をより優れたものにすることもありうる。こうしたリスクは人類が引き起こすものである以上、人類によって避けられるものでもある。しかし、協調することの困難さが人類に立ちはだかる。例えばロシアが軍備を縮小しないのは、そうすればロシアはアメリカに対して劣位に置かれることになるからであり、その逆もまた真だ。どちらの国にとっても核戦争の可能性がなくなれば、それに越したことはないにもかかわらず。

しかし、例えば外交関係を改善したり、より優れた国際機関を発達させることによって、ひとつの文明としての私たちの協調能力を改善することは可能かもしれない。この種の提案に関する研究が進むことを我々は望んでやまない。

〈善いことをする〉ための教育の改善や国際開発などの主流の取り組みも、社会のレジリエンスを高め、より賢い社会を実現し、それによって破局リスクの減少に寄与する。例えば、よりよい教育を受けた人民はより聡明な指導者を選び出すかもしれないし()、より豊かな国々は、その他の点が等しければ、よりうまくパンデミックを予防することができる ── 西アフリカの最貧困地区の一部でエボラ熱が定着してしまったことは偶然ではないのだ。

しかし我々は、ふたつの理由から、教育や健康が、焦点を当てるべき最善の領域であるとは考えていない。第一に、私たちが取り上げてきたより論争の余地の少ないアプローチと比べて、こうした領域が見過ごされている度合いは極めて小さい。実のところ、教育の改善は、善いことをしたいと望んでいる人びとにとってはおそらく一番人気のある課題領域であり、アメリカ単独でも、8千億ドルの政府資金を受け取り、それとはまた別に一兆ドルの民間資金を得ている。第二に、このアプローチは、存亡リスクの減少に対しては〔他方のアプローチよりも〕ずっと散漫な効果しかもたない。というのも、検知できるほどの効果を得るためには教育をかなり大規模に改善しなければならないからだ。我々は、より目標を絞った、見過ごされている解決策に焦点を当てたいと考えている。

3. 知識を増やし、キャパシティを形成する

どれが最大のリスクで、それに対して何をするのが最善なのか、そして、世界的な優先課題に関する我々の描像全体がまるごと誤っていはしないかどうかについて、我々はかなり確信がもてていない。だからこそ、こうした問題のすべてについてより深く学んでいくことがもうひとつ重要な目標になるのだ。

単純に存亡リスクを減らそうと試みたり、どんな進捗が可能なのかを理解することを通じて、知識を増やすことができる。しかし今現在、知識を増やすための重要な、しかしもっとも見過ごされている方法は、世界的優先課題研究に取り組むことだ。

これは経済学と哲学の学際領域で、人類にとって最も重要な問題のうちでもさらに高次の段階にある問題に答えることを目指している。こうした問題にフルタイムで取り組んでいるのは一握りの研究者しかいない。

不確実性に対処するまた別の方法は、我々がもっと多くの情報をもった未来の時点で活用できるような資源を今から蓄積しておくことだ。そのひとつのやり方として、お金を稼ぎ、貯めておくことがある。将来により多くを達成することができるように、キャリア資本、特に移転可能な技能や影響力のある人脈に投資することもできる。

しかし、このどちらよりも優れている可能性のあるアプローチは、存亡リスクの減少に集中して取り組むコミュニティを ──それが具体的にどんなものになるのかはさておき──形成することにある。このアプローチがより優れたものでありうるのは、あなたが自分個人の富やキャリア資本を増やすよりも速く、コミュニティのキャパシティを増やすことができるからである。例えば、ターゲットを絞って1対1のアウトリーチに一年を費やすなら、適切な専門性を備え、仲間になってくれる他人が見つかることも無きにしも非ずだ。これは、この課題領域に対して年間約100%のリターンとなるだろう。

今現在、我々は、効果的利他主義のコミュニティを作り上げることに注力している。このコミュニティには、存亡リスクを減らしたいと望む沢山の人たちがいる。さらに、最近の成長率と、当コミュニティを成長させるための特定の努力に関する研究が示しているのは、リターンの割合を高くすることが可能であることだ。

しかし我々は、他のコミュニティを形成する努力も価値をもつだろうと予測している。アカデミアで、安全性の文化を推し進めようとする科学者共同体が現れたら素晴らしいことだろう。存亡リスクの減少に取り組みたいと望む政策立案者のコミュニティが現れ、政府がもっと将来世代に関心をもつようにしてくれるなら、それも素晴らしいことだろう。

存亡リスクの減少に積極的に取り組んでいる人間が少ないことを踏まえて、我々は、このリスク周りの運動を形成するためにできることは沢山あると期待している。

全体でみると、存亡リスクの減少はどれくらい効果的なのか?

存亡リスクを減らすあらゆるアプローチと、そのいくつかに投入されている資源があまりに少ないことを考えるなら、十分な進歩を生むことは可能であるように思われる。

実際、(将来世代への利益を考慮からはずし)現世代に対する存亡リスクのインパクトだけを考えた場合でさえも、存亡リスクはおそらく最優先課題であるだろう。

存亡リスクの現世代への影響に限っても、これが最優先課題でありうる理由を簡単に素描するために、以下に大まかで単純化された数値を挙げよう。存亡リスクを減らすために1千億ドルを費やしたとしたら、次の一世紀に渡ってその脅威を1%以上減らすことができるのは、もっともらしいように思われる。存亡リスクが1パーセント減ることは、現世代の約1億人を救うことになると予想される(いま生きている約100億人のうちの1%)。つまりこの投資は一人当たり1,000ドルしかかからずにその命を救うのだ。28

グレッグ・ルイスは、より詳しい推定を出し、現世代で生存年数一年当たり9,200ドル(あるいは一名の人命ごとに約300,000ドル)という平均値に辿り着いた。29 より詳しい推定も、このスレッド内にある。グレッグはあまりに保守的であるように我々には思われる。というのも彼は、次の一世紀に渡って滅亡するリスクはわずか1%だと想定しているのだが、我々の見積もりではその値は何倍か高いからだ。存亡リスクを減らすのに費やされた次の10億ドルはグレッグが想定するよりも大幅のリスクの削減をもたらしうる(ただしその10億ドルが、AIセーフティやバイオリスクなどの最も見過ごされている問題に費やされる場合にのみ、今述べたことは成り立つ)。結果として、存亡リスクの削減に投資される次の10億ドルに関しては、現在生きているひとりの人命にかかるコストは100$以下になったとしても、我々は驚かないであろう。

GiveWellの推奨慈善団体、Against Malaria Foundation(AMF)は、現世代を助けるための最善の方法のひとつとしてしばしば紹介され、約7,500ドルでひとりの命を救う(2017年の数値)。30 それゆえ上記の推定によれば、現世代の命を救うことについても、人類の存亡にかかわる脅威の減少は、AMFと同じくらいの費用対効果になるのだ。

同様に、10,000人の才能ある若い人たちが自分たちのキャリアを存亡リスクに集中させるなら、このリスクを1%ほど減少させるだろうと我々は考えている。つまり現世代がそのキャリアを通じて、ひとりあたり1,000人の命を期待値として救うことになる。これはおそらく、与えるために稼ぎ、Against Malaria Foundationに寄付することで救うよりも優れている。31

ある意味ではこの比較にはフェアじゃない部分がある。というのもGiveWellの推定はずっと堅実で、よく研究されているが、我々の推定はむしろ情報を踏まえた上での憶測に近いものだからだ。AMFよりも現世代を助けるより優れたやり方もあるかもしれない(例えば政策アドボカシーなど)。

しかし存亡にかかわる脅威を減らすことで得られる利益について、我々の理解は劇的に進んできてもいる。文明を保護する主な理由は、現世代ではなく、将来世代に利益をもたらすことにある。我々が目下検討中の推定では、将来世代を無視していた。

将来世代も考慮に入れるなら、存亡にかかわる脅威を減らすことの効果は桁違いに高くなり、現段階でそれ以上に切迫した優先課題は考えつかない。

ここでこうした議論への反論を読むこともできるし、あるいはそれは飛ばして、実際的にこの課題領域に貢献するための方法へと進んでもいい。

いったい誰が未来を守ることを優先しないのか。

上に提示した議論は一部、誰もが受け入れるわけではないだろう想定に依拠している。こうした議論に対する比較的優れた反論の一部を以下に挙げる。

友人や家族にもっと注意を向けるべきだ

我々が話してきたのは、もしもあなたが誰しもの利害を等しく扱って人びとを一般に助けようとしているとしたら(哲学者たちがときおり「不偏的利他主義」と呼ぶものだ)、何が優先課題となるべきかということだけだ。

ほとんどの人間は他者を助けたいという気持ちをある一定程度持っている。すなわち、赤の他人をほんの少しのコストで助けられるなら、そうすることは善いことだと考えている。人びとは自分自身の人生がうまくいくことに気をかけており、自分の友人や家族を世話してもいる。みんなそうだ。

しかしこうした優先事項のあいだでどうバランスを取るべきかというのは難しい問題だ。もしもあなたが世界に貢献することができるような幸運な立ち位置にいるとしたら、あなたが焦点を当てるべきは未来を庇護することであると我々は考える。次節では、この運動に参加するための具体的な筋道を列挙する。

さもなければ、あなたは今すぐあなたの個人的な生活に力を注ぎ、その合間に貢献するか、あるいはもっと先の未来に、貢献する必要があるかもしれない。

存亡リスクは我々が論じてきたよりもずっと小さい

多くの人為的な〔破局〕リスクに関して我々は確固たる推定をもつわけではない。だからあなたが自分自身の推定を行ってみて、人為的な〔破局〕リスクが我々が算出したよりもずっと低いと結論することはありうる。リスクが十分低ければ、そのリスクを減らすことは、最優先課題ではなくなるだろう。

上に述べた理由から、人為的な〔破局〕リスクがそれほど低いということがありそうだとは我々は思わない。すべての潜在的リスクを考えてみるなら、そのリスクが今世紀を通じて1%以下であるということに確信を持つのは難しく、おそらくは1%のリスクさえ、我々が今目撃しているよりもずっと多くの活動の必要性を正当化するだろう。

存亡リスクについて我々にこれ以上できることはほとんどない

存亡リスクはグローバル・ヘルスのような問題よりも「解決可能性」は低いと我々は評価し、1ドル毎に産み出せる進捗はより難しいものになるだろうと予測している。そう述べた上で、しかし存亡リスクの規模と見過ごされている度合いは、この不足を補って余りあり、結局、期待値としてはより効果的だ。効果的利他主義とは「証明済みの」介入策だけを支持することであると多くの人が考えているが、しかしそれは神話だ。もしも利点が十分に大きければ、報われる確率が僅かでしかないような介入策を取る価値はある。このコミュニティーで指導的立場にある資金提供者はいま「ヒット・ベースの寄付」アプローチを提唱している。

しかしもしあなたが進歩の可能性について我々よりも遥かに悲観的であるとしたら、グローバル・ヘルスのようなもっと従来型の問題に取り組んだ方がよいかもしれない。

個人的には、破局リスクを減らすために今とは二桁以上多くのリソースが投入されていたら、我々は別の問題に移っていたかもしれない。しかし今のところ、そうなるまでにはかなり長い道のりを必要とする。

これに関係して、存亡リスクを減らすために我々は既に最善の介入策をとっているという反論がある。つまり存亡リスクは実践上の優先事項の変更を正当化しないというものだ。例えば以前に言及したように、教育はおそらく存亡リスクを減少させるのに役立つ。もしもあなたが、教育が最良の対応策であると(たぶんどのリスクが最も切迫しているのかがあまりに不確かなために)考えるなら、我々は既に巨額の資源を教育に投入しているのだから、問題は既に対処されていると考えるかもしれない。我々はこれがもっともらしいように思えない。というのも既に挙げたように、存亡リスクを減少するためのより的を絞った、しかし見過ごされているように思われる未着手の取り組みが沢山あるからだ。

これとまた別の例は、経済成長だけに集中すべきだという時折経済学者から聞かれる主張だ。彼らによれば、経済成長こそが、我々を未来のリスクに対処するのに、可能な限りで最も良い立ち位置に置くことになる。我々にはこれがもっともらしいようには思えない。なぜならあるタイプの経済成長は、破局リスク(例えば新兵器の発見)を増加させ、それゆえ経済成長が存亡リスクを減らす最も良い方法であるかは明らかではないからだ。その代わり、我々は少なくとも、技術発展の差別化(differential technological development)や、上に挙げた、より的を絞った他の努力に焦点を当てるだろう。

未来のためになるもっといい方法がある

存亡リスクの減少は現世代にとっても価値があるかもしれないが、その重要性の多くはそうしたリスクの長期的な効果から来るものだ──一度文明が終焉を迎えるなら、全未来を放棄することになる。

現世代に着手することができ、かつ極めて長期にわたる効果をもつ他の活動があるのであって、こうした活動は滅亡のリスクを減少するのに同程度に重要でありうると考えるかもしれない。特に、我々の文明が永久的に悪い状態へと押し込まれてしまうのを避けることで、未来の質を改善することができるかもしれない。SFじみてくるが、辛抱してほしい。これまでずっと指摘されてきたひとつの可能性は、度を越した監視や心理的条件付けといった新しいテクノロジーが、終わることの決してない全体主義国家の誕生を可能ならしめるというものである。前者は『一九八四年』、後者は『すばらしい新世界』のシナリオだ。もしこの政府が悪い政府なら、何千年にも渡る苦しみをもたらすことで、人類文明は滅亡するよりも悪い運命をたどることになるだろう。

進化したAIシステムの開発は、おそらくはそのテクノロジーを開発する、勃興する複数の団体の間に競争があるために無責任に進められるなら、深刻な害をもたらすかもしれないという懸念も持ち上がっている。特に、将来のある時点で、AIシステムの発展により感覚をもった、0と1から成る心(sentient digital mind)が創造されるなら、その福利も極めて重要になってくるかもしれない。天文学的な量の苦しみが存在する未来が到来するリスクは、「Sリスク」と呼ばれてきた。31 Sリスクが生じるのを避けるために今我々にできること(たとえば、AIセーフティ技術やAIガバナンスを標的とする研究など)があるとすれば、それはさらにより重要であるかもしれない。

目を向けるべきまた別の領域は、テクノロジーの大きな変革である。遺伝子工学や人工知能の危険性についてはこの記事のなかで言及してきたが、しかしこうしたテクノロジーがひとたび利用されるようになれば、第二次産業革命をもたらし、莫大な量の善い結果をもたらすかもしれない。悪い変革ではなく善い変革の確率を増すために我々にできることがあるかもしれない。これは「存亡リスク(existential risk)」を減らすというより「存在希望(existential hope)」を増やそうとすることだという言い方がされてきた。32

多大な、長期的な影響を持てるやり方が他にもあるかもしれないということには同意するし、そうした方法は人類滅亡のリスクを減らすよりも切迫しているかもしれない。しかしこうした提案のほとんどはまだ十分に取り組まれておらず、そうした提案について何をすべきかも定かでない。

将来にインパクトをもたらすこうした他の方法を考察したことによる実践上の帰結は、AIのような、革新的な、新たなテクノロジーへの移行を善い方向にコントロールするほうがさらにもっと重要であると考えられるということだ。この帰結は、こうした問題を調べる世界的優先課題研究をより注視することに我々の関心を向けさせる。

全体的に見れば、人類の存亡にかかわる脅威の減少にまずは焦点を当て、そのあとで未来を善くすることに貢献する他のやり方に注意を向けるというのが、理にかなっているように思われる。

未来に貢献するもうひとつの方法で、我々のアプローチの候補に上がらないように思われるのは、未来に進む速度を増すことだ。未来に貢献することを望む一部の人々は、新ワクチンの開発など、技術的進捗を引き起こすことに注力しており、これが長期的な利益を生みだすことは確かである。しかし長期的観点からもっとも重要なことは、我々がどこに行き着くかであって、行き着くその場所にどれくらい速く行き着くかではない。新ワクチンの発明によっておそらく我々は、それによってはじめて、その場所に辿り着くことができるようになるというよりも、〔遅かれ早かれ辿り着いていたであろうその場所に〕より早く辿り着くことになる。さらにテクノロジーは多くの存亡リスクの原因でもあるのだから、短期的に見て、発展の速度を増すことがどれほど助けになるのかは、定かでない。

進歩を加速することが、見過ごされているとは全然言えない。というのもそれは現世代にも利益をもたらすからだ。既に取り上げたように、毎年、1兆円以上が新しいテクノロジーを開発するR&Dに費やされている。つまり、進歩の速度を上げることは重要度が低く、かつ見過ごされてもいない。

将来世代を助けるための他の方法についてもっと読みたい場合は、ニック・ベックステッドの『遠い未来をかたちづくることが途方もなく重要であることについて(On the Overwhelming Importance of Shaping the Far Future)』の第3章をみよ。

未来はそんなに長く続かない、あるいは悪いに決まっている

文明が長くは続かないことはほとんど保証されていると考えるなら、存亡リスクを減らす価値は相当程度、失われる(それでも、現世代を支援し、僅かな数の将来世代を助けることに取り組むことには、まだ価値があるかもしれないが)。

文明が近いうちに終わりを迎えるかなりの確率が存在することには同意する(だから存亡リスクの問題が重要なのだ)が、文明が極めて長い期間存続する十分に大きな可能性が存在し、だからこそ未来には勝ち取る価値があるのだと我々は考える。

同様に、未来は善くなるよりも悪くなりそうだと考えるなら(あるいは我々が、福利を増すよりも苦しみを減らすことのほうにずっと多く義務を負うとしたら)、存亡リスクを減らす価値は下がる。しかしこれがもっともらしいようには思われない。なぜなら未来が善いものであることを人びとは欲して(want)いて、だから我々は未来を悪いものではなく、善いものにしようとする(try)

であろうからである。また、我々は過去数世紀の間に(前述の傾向により)かなりの道徳的進歩があったと考えるし、道徳的進歩が続いていくことについても楽観的な見通しをもっている。より詳しくは脚注11を見よ。11さらに、未来がどれほど善くなるのか確信を持てなくても、あるいは、未来は、回避できたはずの様々な仕方で悪いものになるのではないかと疑っていたとしても、文明が存続し、文明が選べる選択肢を残してはおきたいのではないだろうか。未来の人びとは、文明を広げていくか、同じサイズに留まるか、あるいは縮小するか、そのどれが望ましいのかを研究するための時間を今よりもずっと沢山持つだろう。もしこうした道徳的な関心事に基づいて行為することができるようになる十分な可能性があると考えるなら、そのことは、何であれ最終的な決断は、将来世代の叡智に任せるほうが善いと考えられるよい理由になる。全体的に見れば、これまでの大局的な問題にはかなり不確かな部分が多いものの、しかしそれによって我々はむしろ、取り返しのつかない仕方で自分たちのエネルギーと時間を投入することにもっと注意深くなるだけの話だ。33

そしてそれ以上に、Sリスクを避けるなど、未来が悪いものとなる確率を減らす様々な手段に注意を向けるべきだ。

我々は〔将来世代よりも〕現世代を助けることのほうに、より強い道徳的義務を負っている

将来世代よりも現世代に対してずっと強い道徳的義務を我々は有していると考えるなら(例えば人格影響説という倫理的見解はそう考える)、存亡リスクを減らすことの重要性は下がる。我々としては、その種の見解が特別説得力を持つようには思われない。

そう述べた上で我々は、将来世代を無視したとしても、存亡リスクには取り組む価値があるように思われると論じてきた。提案されている様々な努力は、現世代の人命を救うにも比較的安価に済むかもしれず、中規模の災害から来る苦しみの多くを避けられるかもしれない。

それ以上に、自分が将来世代に対して道徳的な義務をもつのかどうか不確かだとしたら、やはり自分で選べる選択肢を残しておくようにすべきで、これはつまり文明を保護することである。

それでもなお我々は将来世代に大した道徳的義務は持たないし、かつ、当のリスクは比較的解決しがたいものである(あるいは、なされるべき有用な研究など存在しない)と考えるなら、現世代を助けるまた別の方法が最優先課題として浮上してくる。つまり、グローバル・ヘルスやメンタル・ヘルスに取り組むことになるだろう。あるいは、工場式畜産のようなより重要なまた別の道徳的問題があると考えるかもしれない。

- ^

本文中の注に関しては原文を参照してください。

- ^

ここで原語は「catastrophic risks」であり、文字通りに訳せば「破局リスク」だが、この記事の執筆者はこの概念を定義しておらず、かつこれ以降の議論でこの語は存亡リスクと同義的に用いられていると理解できる。存亡リスクについてはEA Forumのこちらの記事で詳しく説明されている。

- ^

訳者が調べる限りでは、他に「原子レベルでの超精密加工」(Atomically Precise Manufacturing)や「原子操作(Atom Manipulation)」とも呼ばれている。

- ^

この記事が最初に公開されたのは2017年であり、その当時の数字が残っている。現在、AIのセーフティ分野にフルタイムで取り組んでいる研究者の数は20人をはるかに上回っている。この訳中はLuis Costigan氏に負う。