This is a Japanese translation of “The longtermist AI governance landscape: a basic overview”

by Sam Clarke 2022年1月18日

目的:長期主義的なAIガバナンスで何が起こっているのか、基本的な概要を説明する。

対象者:長期主義的なAIガバナンスにあまり馴染みがなく、より理解を深めたい人。すでにこの分野に精通している人の参考にはならないかと思う。追記:すでにこの分野にかなり精通している人の中にも、これが役に立ったと言う人もいる。

この投稿では、長期主義的なAIガバナンスで起きているさまざまな種類の活動の概要を説明する。それぞれの種類の活動について、それを説明し、例を挙げ、それがどのようにポジティブなインパクトを与えることができるかについていくつかのストーリーを描き、私が知っている現在その仕事に取り組んでいるアクターをリストアップする。[1]

まず、いくつかの定義について。

- AIガバナンスとは、AIシステムの開発・配備による社会的成果に影響を与える、ローカルおよびグローバルな規範、政策、法律、プロセス、政治、制度(政府だけではありません)を作り上げていくことを意味する。[2]

- 特に長期主義的なAIガバナンスは、AIの超長期的な影響への懸念に動機づけされたこの活動のサブセットである。これは、変革的AIをガバナンスすることを目的とした活動と大きく重なる。

注目すべきは、長期的視点に立ったAIガバナンスの分野は非常に小さいということだ。超長期的なインパクトへの懸念に立脚しているAIガバナンスの研究者は、60人程度と推測される。

概要

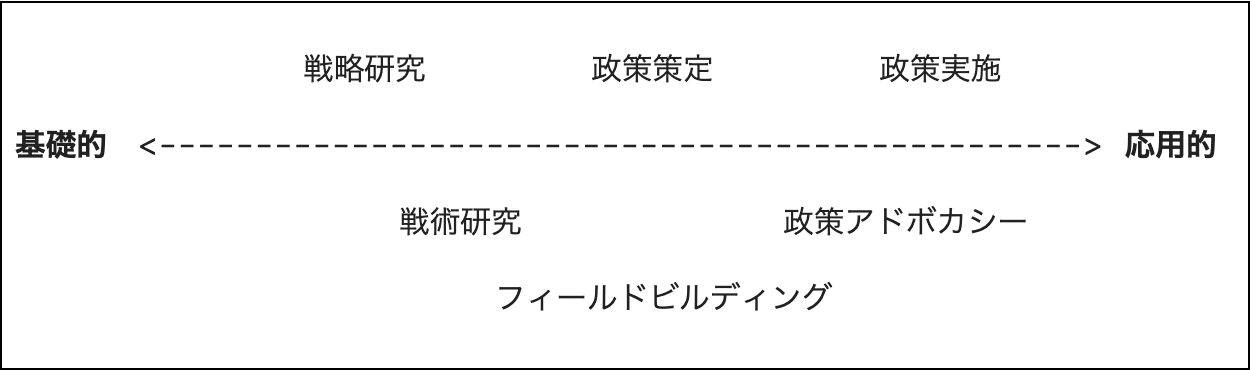

現在行われている研究は、大まかに言えば基礎的な研究と応用的研究の間の連続した分布のどこかに分類できると考えるのがわかりやすい。基礎的な研究としては、長期主義的なAIガバナンスのための優れた高位の目標を定めることを目的とした戦略研究やその高位の目標を達成するための計画を定めることを目的とした戦術研究といったものがある。応用面では、このような研究を具体的な政策に落とし込む政策策定、政策の実施を提言する活動、そして実際に(公務員などによって)政策を実施する活動がある。

また、フィールドビルディングといった仕事もある。(この仕事は先ほどの分布の中の明確な分類には当てはまらない。)この仕事は、問題に直接貢献するのではなく、その問題に対して価値ある仕事をしている人たちのためのフィールドを構築することを目的としている。

もちろん、この分類は単純化したものであり、すべての研究がここで紹介した1つのカテゴリーにきちんと収まるわけではない。

また、一般的には、研究の知見が基礎的な研究から応用的な研究へと順番に影響していくと思うかもしれないが、実際はそれぞれの研究が現実的な政策的としての関心ごと(例:その研究自体が、政治的に実現可能な政策提言につながる可能性がどの程度あるのか)に配慮していることも重要なので、一概にそうとは言えない。

次はそれぞれの研究内容についてより詳しく説明する。

研究

戦略研究

長期主義的なAI戦略研究の最終的な目的は、長期主義的な視点から、私たちが追求することで高度なAIが最終的に良い結果をもたらす確率を明らかに高めるような高位の目標を特定することだ(Muehlhauserに倣って、この目的を「戦略の明確化」と称することもある)。

この研究自体も、ターゲットされた(目的を絞った)戦略研究と探究的な戦略研究との間のゆるやかな分布のどこかに分類することができる。

- ターゲットされた戦略研究(目的を絞った戦略研究)は、研究をすることで、他の具体的で重要な既知の問題を解明するようなものである

- 例:「人間の脳がどの程度の計算量を使うのか知りたい。変革的AIがいつ実現されるのかという問いに答えるのに役立つから(これは、我々がどの上位の目標を追求すべきなのかに影響する)」。

- 探究的戦略研究は、研究することで、他のどの重要な質問に答えるのに役立つかが研究する前にはわからないような質問に答えている

- 例:「中国の産業政策がどのようなものかを調べたい。なぜなら、この調査をすることでおそらくたくさんの重要な戦略的問題の答えを出すのに役立つからだ。

事例紹介

- 変革的AI予測研究、例:生物学的アンカーやニューラル言語モデルのスケーリング法則など

- 戦略にどう関係するのかの例:変革的AIの実現が近い場合、大規模な専門家集団をゆっくり育てることはあまり期待できないように思われる。変革的AIの実現がかなり先になるのであれば、長期的な視点に立ったAIガバナンスは比較的優先されないだろう。

- AIによるx-risk(存亡リスク)のリスク源を明らかにする研究。例:Christiano, Critch, Carlsmith, Ngo, Garfinkelによる記事

- 戦略にどう関係するのかの例:もしAIによるx-risk(存亡リスク)のほとんどが異常化した(アラインしていない)高度AIエージェントに由来するのであれば、ガバナンスはそれらの高度なAIを開発する最初の関係者達に影響を与えることに焦点を当てるべきだろう。

- 変革的AIを中心としたAIの進歩の速さを調査する研究、例:AI Impactsによる調査・分析など。

- 戦略にどう関係するのかの例:もしAIの進歩が不連続的に起こるなら、ハイステークスのアクター(影響力の大きいアクター)は少数になる可能性が高く、ガバナンスの価値の大半はそれらのアクターに影響を与えることから生まれるだろう。

一般的に、戦略研究(特に探索的戦略研究)は、広範囲を対象とする研究と混同されがちである。しかし、実際には、上記の例の多くが示すように、戦略研究は狭い範囲を対象とすることもでき、かなり狭い問いに答えることもできるのである。

広範な質問と狭い範囲の質問の例:

- スケーリング法則について:

- 広範な質問:一般的に、深層学習モデルの性能は、それらのモデルのサイズを増加させるとどのように変化するのだろうか?

- さらに狭い範囲の質問:特に大規模言語モデル(例:GPT-3)の性能は、それらのモデルのサイズを増加させるとどのように変化するのか?(この論文で取り組まれた質問)

- AIのx-risk(存亡リスク)のリスク源について。

- 広範な質問:一般的に高度なAIはどれほどのx-risk(存亡リスク)をもたらすか?

- さらに狭い範囲の質問:その中でも影響力追求型のAIエージェントによってどれだけのx-risk(存亡リスク)がもたらされるか? (このレポートで扱われている質問)

実際、特に若手研究者にとっては、スコープを絞った狭い範囲の質問を選ぶ方がより扱いやすい傾向があるので、そうすることが良い場合が多いと思う。

Luke Muehlhauserは、このような研究に挑戦したい人に向けて、いくつか推奨事項を述べている:この投稿のポイント4を参照。また、オープン・リサーチ・クエスチョンの例については、こちらの投稿を参照。[3]

インパクトを与えるためのストーリー

- 直接的なインパクト:AIガバナンスでは、数多くの目標が存在しうる中で、最も重要なものを優先する必要がある。これらの研究の動機は、研究者が「私たちが追求すべき(AIガバナンスの)戦略目標に影響を与えるテーマが何であるかが不明確だ」という印象を抱いていることにある。例えば、AI x-risk(存亡リスク)のシナリオとx-risk(存亡リスク)の総量について、それぞれ大きく意見が分かれているを示しているこれらの調査結果をご参考に。

- 間接的なインパクト:

- フィールドビルディング:私たちが何を目指しているのか、そしてそれがなぜ重要なのかを明確に理解することで、より多くの人をこの分野に呼び込むことができる。

- 政策変更の必要性を伝える:今後、人々にとってコストのかかることや革新的なことをするように説得したいのであれば、私たちが何を目指しているのか、そしてなぜそれが重要なのかについて、明確な説明を用意しておくとよいだろう。

誰が取り組んでいるのか?

以下の機関の人々:FHI, GovAI, CSER, DeepMind, OpenAI, GCRI, CLR, Rethink Priorities, OpenPhil, CSET,[4]及び独立した学者たち。

戦術研究

長期主義的なAIの戦術研究は、最終的には(戦略研究が優先すべきとした)高位の目標を達成するための計画を特定することを目的としている。その性質上、より狭い範囲を対象とする研究になる傾向がある。

なお、優先すべき目標が明確に特定されていない場合でも、自分自身の学習のため、キャリア資本のため、学問分野の構築のためなどの理由で戦術研究を行うことができるということは注目に値するだろう。

事例紹介

- 「Windfall」条項(将来的に、AIから得られる利益が極端かつ予想外に大きい場合(Windfall profit(超過利潤)と認定)、AI企業が共通善のために利益を分配することをあらかじめ義務付けるもの)

- 計画:共通善のためにAIの利益を分配するためのツールを開発する。

- この計画が追求する高位の目標:高度なAIを最初に開発するためにアクター同士が競争するインセンティブを減らし、経済的不平等を軽減する。

- 検証可能な主張をサポートするメカニズム

- 計画:AI開発者が、AI開発に関する自らの主張をより検証可能なものにする(つまり、開発者が説明責任を持てるような主張をする)ための手法を開発する。

- この計画が追求する高位の目標:AIシステムの責任ある行動を実証するメカニズムの開発、より効果的な管理体制の実現、競争力を得るために手抜きをするプレッシャーの低減。

- AIと独占禁止法

- 計画:競争法と協調的なAI開発の必要性との間の緊張関係を緩和する方法の提案

- この計画が追求する高位の目標:高度なAIを開発する企業間の協力関係を強化する。

インパクトを与えるためのストーリー

- 直接的なインパクト:(政策や将来の研究において)より良い意思決定を下すために役立つ解決策を生み出すこと。

- これは、Allan Dafoeの言う「研究の製品モデル」である。

- 間接的なインパクト:たとえすべての解決策がより良い意思決定に役立たなかったとしても、長期主義的なAIガバナンスの問題に関心を持つ人々のフィールドを拡大し、研究者の洞察、専門知識、人脈、信頼性を向上させることに貢献する。

- これは、Allan Dafoeの言うところの「研究のフィールドビルディングモデル」である。

誰が取り組んでいるのか?

以下の機関の人々:FHI, GovAI, CSER, DeepMind, OpenAI, GCRI, CSET, Rethink Priorities, LPP, 及び独立した学者たち。

政策立案・アドボカシー・実施

戦略研究は、高位の目標を導き出す。戦術研究は、それらの目標を達成するための計画を立てる。政策立案活動では、これらの計画を政策提言に落とし込み、政策立案者に提供する。そのためには、例えば、具体的にどのような提言をするか、(正式な政策と提言の両方において)どのような言葉を使うか、その他実施の成功確率に影響を与えるコンテクスト特有の特徴を見極める必要がある。

政策アドボカシー活動とは、政策が実施されるよう提唱する活動である。例えば、「誰に対して政策提言をするのか?」、「どのタイミングで政策提言をするのか?」、そして「その政策提言を誰がするのか?」に関して最適解を見極めることである。

政策実施とは、公務員や企業などが実際に政策を実施する作業である。

政府政策(政府や政府間組織によって制定されることを意図した政策)と企業政策(企業によって採用されることを意図した政策)を区別することには価値がある。長期主義的なAIガバナンスに取り組む人々の中には、企業政策(特にAI開発者のための政策)の改善に重点を置く人もいれば、関連する政府の政策の改善に重点を置く人もいる。

政策立案を成功させるためには、実施の詳細が極めて重要であるという認識がすべての政策活動に共通する動機だ。例えば、政府の規制に微かな抜け穴があると、その規制が無意味になってしまう。

研究と比較すると、この種の仕事は一人で考えることが比較的少なく、会話や情報収集(例:ある政策に対して誰が権限を持っているか、彼らが何を気にしているか、他のプレイヤーは政策に何を求めているかを知るために会議を開く)、そして調整(例:ある政策を支持するようにアクターのグループに対してどう働きかければいいかを考え、それを実現する)がより多い傾向がある。

先ほど述べたように、政策の洞察は時に「逆流」する。例えば、政策立案は、アドボカシーによって自分の知識(と政策の展望)がどのように変化するかに基づき、反復的に行われるかもしれない。

事例紹介

- 政府政策

- AI技術を原子力の指揮・統制・通信(NC3)に組み込まないことを約束すること。例えば、CLTRがFuture Proofレポートで提唱しているように。

- 政府によるAI開発の監視。例:AI監視に関するこのホワイトペーパーで詳しく述べられているようなもの

- 高度なAIシステム(現在のものも含めて)のリスクを考慮した初期の規制やAI戦略・原則を定めること。例えば、EUのAI法に対して様々なEA組織によるフィードバックなど。

- 企業政策

- AI研究が悪用される可能性を考慮し、責任を持って普及させるための規範を整備すること。例:PAIによるこれらの推奨事項など

これらのアイデアは、より対象を絞ったもの(例:AIをNC3に統合しない)から、より一般的なもの(発生するであろう幅広い種類の問題に対処するための汎用的能力を備えるという意味で。例:上述の他のほとんどの問題など)まで、さまざまだ。私は今日の私たちの政策立案、アドボカシー、実施はより一般的なアイデアに集中すべきだと思う。なぜなら、今後AIがどのように展開するのかというのが我々にとって不透明だからである(一方で、明らかに優れた特定のアイデアが生じた場合には、それを推進することも必要だ)。

インパクトを与えるためのストーリー

- 直接的なインパクト:優れた政策を実施することで、高度なAIが存在する世界への移行をうまく舵取りできる可能性が高まる。

- 間接的なインパクト:たとえある政策アイデアが確実に良いものであると確信できなくても、それを開発/提言/実施することで、長期的にAIガバナンスを担う人々の洞察、専門知識、人脈、信頼性を構築することができる。AI「クランチタイム(正念場)」[5]になってから、政策策定や意思決定の方法について学び始めるようなことは避けるべきでしょう。

- とは言え、結果的に有害となるような政策の実施には十分注意する必要がある。例:将来の政策策定を制約するなど

誰が取り組んでいるのか?

- 立案:

- アドボカシー:

- 実施:

フィールドビルディング

この仕事は長期主義的なAIガバナンスにおいて価値ある仕事をしている人々のフィールドやコミュニティを成長させることを明確な目的としている。[6]この仕事は、(1)新しい人々を引き入れることと、(2)この分野をより効果的にすることの両方を含んでいると考えることができる。

事例紹介

1. 新しい人を引き入れるために作るもの:

- OpenPhil Technology Policy Fellowshipのような政策フェローシップ。

- AIガバナンスで起きていることを若手が把握するためのオンラインプログラムやコース。

- 高品質で幅広い層が興味をもてる多くの学部生に届くような入門教材。

- 関心を持つ若手をつなぎ、支援し、資格を付与するための、よりスケーラブルな研究フェローシップ。

2. フィールドをより効果的にするために作るもの:

- 研究課題

- 上級研究者が研究助手を簡単に雇えるようにする手段。[7]

インパクトを与えるためのストーリー

- 成長モデル:重要な研究と政策の仕事(特にこの仕事において戦略が明確でないことがボトルネックになっていない場合)をする能力と関連する専門知識を持った多くの連携した人々とともに長期主義的なAIガバナンスのフィールドを構築する。

- メトロポリスモデル:[8]より広いコミュニティ(例:政策立案、社会科学、機械学習など)と密なつながりを持ち、これらのコミュニティから多様な専門知識を引き出せるような長期主義的なAIガバナンスのフィールドを構築すること。

誰が取り組んでいるのか?

GovAI, OpenPhil, SERI, CERI, CHERI, EA Cambridgeなどである。より広い視野で見れば、特定の課題領域に限らない広範なEAムーブメントのコミュニティビルディングも同様だ。これは、この投稿で議論されている仕事の中で、最も探究されていない種類のものだ。

長期主義的なAIガバナンスの展望についての他の考え方

私は、長期主義的なAIガバナンスの展望の一つの考え方を提示しただけである。もちろんそのほかの目的に対して役に立つ別の考え方もある。例えば、以下のような様々な種類の介入に基づいて、展望を区分することができる。

- 政策議論における既存の議論をAIのx-risk(存亡リスク)に対してより感度が高いものにする(例:最先端のAIシステムを保証することの難しさに対する認識を高める)

- 新しい政策ツールの提案(例:国際的なAI基準)

- AIセーフティ研究への政府からの資金提供

- 企業行動の転換(例:「Windfall」条項)

- …

あるいは、地理的なハブによって区分することもできる。(ただし、すべての組織が地理的なハブに属しているわけではない)。

- ベイエリア:OpenPhil、OpenAI、PAI、様々なAIアライメント組織。平均してAI x-risk(存亡リスク)の原因となるミスアライメントに焦点を当て、文化的にはシリコンバレーや合理性文化(rationality culture)に近い。

- ワシントンDC: 米国政府、CSET。米国の政策立案、アドボカシー、実施に重点を置き、文化的にはDC文化に近い。

- 英国:FHI/GovAI、DeepMind、英国政府、CSER、CLTR、(その他?)。平均してより幅広いAI x-risk(存亡リスク)源に対してより多くの懸念を抱いている。

- EU:2020年、欧州委員会が世界初のAI規制を起草し、この規制が今後数年で成立する可能性が高く、ブリュッセル効果につながる可能性がある。

- 中国

- …

あるいは、さまざまな「勝利の理論」、つまり、人類が高度なAIが存在する世界への移行をどのようにうまく乗り切るかについての複数の完結した物語に基づいて、展望を区分することもできる。この他にも色々言いたいことはあるのだが、この記事の目的は現在行われている活動の種類を簡潔に概観することである。

謝辞:この記事は、私独自の展望の総括ですが、Allan Dafoe, Luke Muehlhauser, Convergence AnalysisによるEAフォーラムの投稿に触発され、さらに直接引用したものです。また、Jess Whittlestoneとの有意義な議論、Matthijs Maas、Yun Gu、Konstantin Pilz、Caroline Baumöhl、特にSERIの査読者の、草稿に対するフィードバックに感謝しています。

この作品は、クリエイティブ・コモンズ表示4.0国際ライセンスの下でライセンスされています。

- ^

I’ve surely forgotten some important groups from this list, and I may have misclassified or otherwise misrepresented some of them - please let me know if that’s the case! ↩︎

- ^

This borrows directly from Open Philanthropy’s definition. ↩︎

- ^

Note that some of these are tactics research questions rather than strategy research questions. ↩︎

- ^

CSET mostly do tactics research, policy development and policy advocacy, but their work on mapping the semiconductor supply chain falls under strategy research. ↩︎

- ^

Muehlhauser defines this as “a period lasting 1-20 years when the decisions most impactful on TAI outcomes might be made”. ↩︎

- ^

This is distinct from the field-building benefits of other kinds of work discussed in this document, since it is solely and explicitly focused on building the field. ↩︎

- ^

Which can also help bring in new people. ↩︎

- ^

This idea directly borrows from Allan Dafoe’s forum post. ↩︎